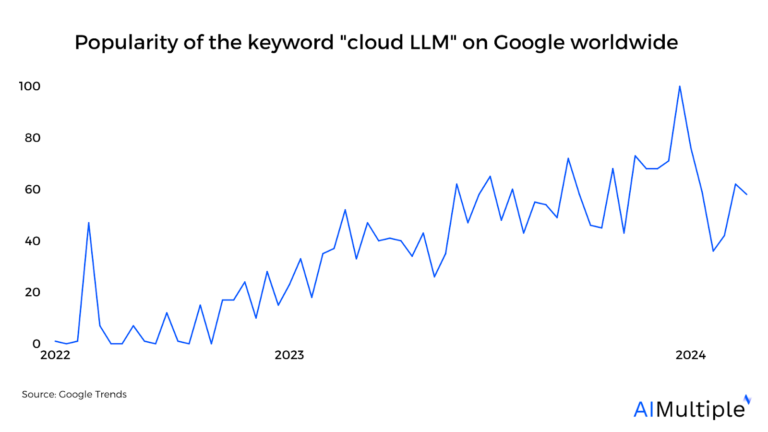

Рисунок 1. Растущая популярность ключевого слова «cloud LLM» в Google с момента выпуска ChatGPT-3.5 в ноябре 2022 года.

Модели больших языков (LLM) стали горячей темой для бизнеса, особенно после выпуска ChatGPT-3.5 на рынок в 2022 году. Интеграция генеративного ИИ в эти модели еще больше расширила их возможности, поставив перед компаниями дилемму между экономической эффективностью и эффективностью затрат. и надежность. В этой статье мы предоставляем читателям подробный обзор облачных LLM, некоторые тематические исследования и их отличие от местных LLM, обслуживаемых собственными силами.

Что такое облачная модель большого языка (LLM)?

Cloud LLM — это большая языковая модель, размещенная в облачной среде. Эти модели, как и GPT-3, представляют собой системы искусственного интеллекта, которые обладают расширенными возможностями понимания языка и могут генерировать тексты, похожие на человеческие. Облачные LLM доступны через Интернет, что упрощает их использование в различных приложениях, таких как чат-боты, создание контента и языковой перевод.

Однако крупные предприятия, несмотря на обширные облачные инициативы и интеграцию SaaS, обычно размещают в облаке лишь 15–20% своих приложений.1 Это указывает на то, что значительная часть их ИТ-инфраструктуры и приложений по-прежнему опирается на локальные или устаревшие системы.

Облачные LLM подходят для:

- Команды с низкотехнологичным опытом: Облачные LLM могут подойти командам с ограниченными техническими знаниями, поскольку они часто доступны через удобные интерфейсы и API, что требует меньше технических знаний для эффективного внедрения и использования.

- Команды с ограниченным техническим бюджетом: Облачные LLM устраняют необходимость значительных первоначальных инвестиций в оборудование и программное обеспечение. Пользователи могут платить за облачные услуги LLM на основе подписки или использования, что может быть более экономичным.

Плюсы облачного LLM

- Никаких усилий по техническому обслуживанию: Пользователи облачных LLM освобождаются от бремени обслуживания и обновления базовой инфраструктуры, поскольку эти обязанности берут на себя поставщики облачных услуг, а затраты добавляются к ценам на подписку.

- Возможности подключения: Доступ к облачным LLM можно получить из любого места, где есть подключение к Интернету, что обеспечивает удаленное сотрудничество и использование географически распределенными командами.

- Меньше финансовых затрат: Пользователи могут получить выгоду от экономически эффективных моделей ценообразования с оплатой по мере использования, сокращая первоначальные капитальные затраты, связанные с закупками оборудования и программного обеспечения, и используя эту модель в любое время, когда им это необходимо.

Минусы облачных LLM

- Риски безопасности: Хранение конфиденциальных данных или использование LLM может вызвать проблемы с безопасностью облака из-за потенциальной утечки данных или несанкционированного доступа. Это может стать бременем для компаний, которые серьезно обеспокоены конфиденциальностью, поскольку они могут быть уязвимы для сложных атак с использованием социальной инженерии.

Что такое местные LLM?

Локальные LLM относятся к большим языковым моделям, которые устанавливаются и запускаются на собственных серверах или в инфраструктуре организации. Эти модели предлагают больший контроль и потенциально повышенную безопасность, но требуют больше технических знаний и усилий по обслуживанию по сравнению с их аналогами облачных вычислений.

Подходит для:

- Команды с высокотехнологичным опытом: Идеально подходит для организаций со специальным отделом искусственного интеллекта, таких как крупные технологические компании (например, Google, IBM) или исследовательские лаборатории, обладающие ресурсами и навыками для обслуживания сложных инфраструктур LLM.

- Отрасли со специализированной терминологией: Выгодно для таких секторов, как юриспруденция или медицина, где необходимы индивидуальные модели, обученные определенному жаргону.

- Инвестировавшие в облачную инфраструктуру: Компании, которые уже сделали значительные инвестиции в облачные технологии. (т. е. Salesforce) может более эффективно создавать собственные LLM.

- Те, кто может инициировать тщательное тестирование: Необходимо для предприятий, которым требуется обширное тестирование моделей на точность и надежность.

Плюсы местных LLM

Операции с высоким уровнем безопасности: Это позволяет организациям сохранять полный контроль над своими данными и способами их обработки, обеспечивая соблюдение правил конфиденциальности данных и политик внутренней безопасности.

Если вы планируете создавать LLM самостоятельно, вот руководство по сбору данных LLM.

Минусы местных LLM

Первоначальные затраты: Необходимы значительные инвестиции в графические процессоры и серверы, что похоже на сценарий, когда технологическая компания среднего размера может потратить несколько сотен тысяч долларов на создание местной инфраструктуры LLM.

Масштабируемость: Трудности с масштабированием ресурсов для удовлетворения меняющихся потребностей, например, с точной настройкой модели.

Проблемы окружающей среды: Обучение одной большой языковой модели может привести к выбросу около 315 тонн углекислого газа.2

Сравнение локальных и облачных LLM

Вот сравнение локальных и облачных LLM на основе различных факторов:

| Фактор | Внутренние программы LLM | Облачные программы LLM |

|---|---|---|

| Техническая экспертиза | Очень нужен | Меньше необходимости |

| Первоначальные затраты | Высокий | Низкий |

| Общие затраты | Высокий | От среднего до высокого* |

| Масштабируемость | Низкий | Высокий |

| Контроль данных | Высокий | Низкий |

| Кастомизация | Высокий | Низкий |

| Риск простоя | Высокий | Низкий |

*Общие затраты могут увеличиться в зависимости от потребностей бизнеса.

Если вы готовы инвестировать в облачные графические процессоры, ознакомьтесь с нашим сравнительным анализом поставщиков.

Как выбрать между локальным и облачным LLM?

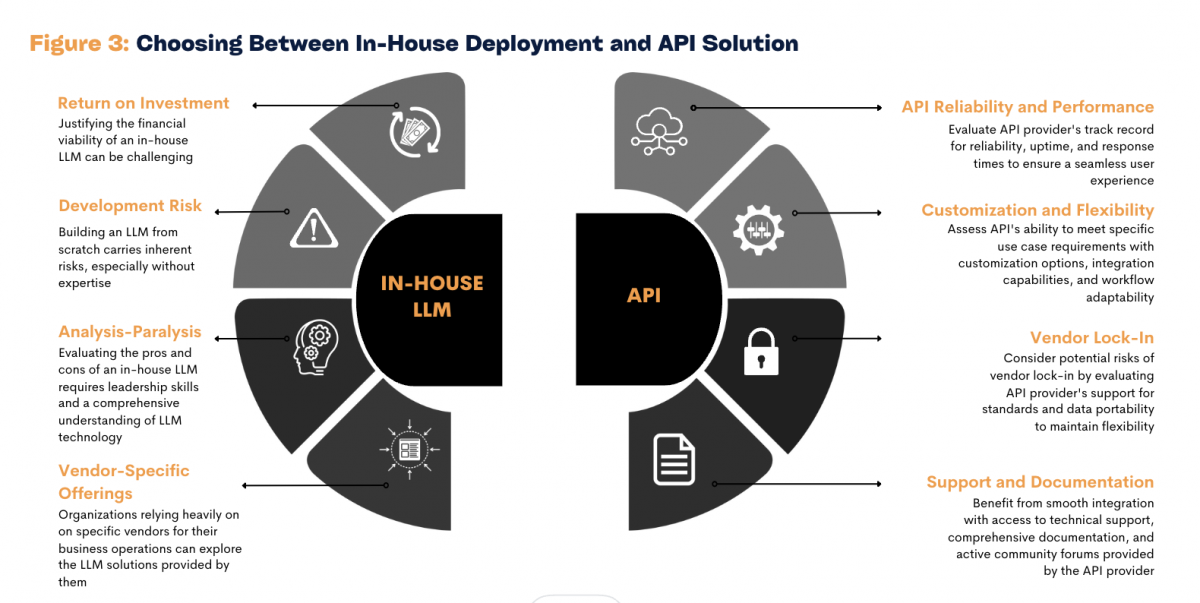

Источник: Исследование AIM.3

Рисунок 1. Внутренние программы LLM по сравнению с API

Выбирая между локальным или облачным LLM, вам следует рассмотреть несколько вопросов:

1- Есть ли у вас собственный опыт?

Для локального проведения программ LLM требуются значительные технические знания в области машинного обучения и управления сложной ИТ-инфраструктурой. Это может стать проблемой для организаций, не имеющих сильной технической команды. С другой стороны, облачные LLM снимают с поставщика облачных услуг большую часть технической нагрузки, включая обслуживание и обновления, что делает их более удобным вариантом для предприятий, которым не хватает специализированных ИТ-специалистов.

2- Каковы ваши бюджетные ограничения?

Локальное развертывание LLM требует значительных первоначальных затрат, главным образом из-за необходимости в мощном вычислительном оборудовании, особенно графических процессорах. Это может стать серьезным препятствием для небольших компаний или стартапов. Облачные LLM, наоборот, обычно имеют более низкие первоначальные затраты благодаря моделям ценообразования, основанным на использовании, таким как подписки или планы с оплатой по мере использования.

3- Каковы ваши вычислительные потребности?

Для предприятий с постоянными потребностями в больших объемах вычислений и инфраструктурой для их поддержки местные LLM могут быть более надежным выбором. Однако облачные LLM предлагают масштабируемость, которая выгодна предприятиям с меняющимися потребностями. Облачная модель позволяет легко масштабировать ресурсы для обработки возросших рабочих нагрузок, что особенно полезно для компаний, чьи вычислительные потребности могут периодически возрастать (например, косметическая компания в сезон Черной пятницы).

4- Каковы ваши активы по управлению рисками?

Хотя местные LLM предлагают более прямой контроль над безопасностью данных и могут быть предпочтительными для организаций, обрабатывающих конфиденциальную информацию (например, финансовые или медицинские данные), они также требуют надежных внутренних протоколов безопасности. Облачные LLM, хотя и потенциально представляют более высокие риски из-за передачи данных через Интернет, управляются провайдерами, которые обычно вкладывают значительные средства в меры безопасности.

3 тематических исследования Cloud LLM

Манц и глубоководное облако

Manz, австрийское юридическое издательство, использовало Deepset Cloud для оптимизации юридических исследований с помощью семантического поиска.4 Их обширная юридическая база данных требовала более эффективного способа поиска соответствующих документов. Они внедрили систему семантических рекомендаций, используя опыт Deepset Cloud в области НЛП и моделей немецкого языка. Манц значительно улучшил исследовательские процессы.

Когниант и Google Cloud

Cowlant и Google Cloud сотрудничают, чтобы использовать генеративный искусственный интеллект, в том числе модели большого языка (LLM), в облаке для решения проблем здравоохранения.5 Они стремятся оптимизировать административные процессы в здравоохранении, такие как апелляции и взаимодействие с пациентами, используя платформу Vertex AI от Google Cloud и отраслевой опыт Cowlant. Это партнерство подчеркивает потенциал облачных программ LLM для оптимизации операций в сфере здравоохранения и повышения эффективности бизнеса.

Союзная банковская корпорация и Финастра

Allied Banking Corporation, базирующаяся в Гонконге, перевела свои основные банковские операции в облако и перешла на решение Finastra Essence следующего поколения.6 Они также внедрили Retail Analytics от Finastra для улучшения отчетности. Этот шаг отражает стратегический сдвиг в сторону современных, экономически эффективных технологий, обеспечивающих будущий рост и повышение эффективности.

Если вам нужна помощь в выборе между локальным или облачным LLM для вашего бизнеса, свяжитесь с нами:

Найдите подходящих поставщиков

- «В поисках ценности облака: может ли генеративный искусственный интеллект повысить рентабельность инвестиций в облако?«. МакКинси. 15 ноября 2023 г. Проверено 16 января 2024 г.

- «Струбелл Э., Ганеш А. и МакКаллум А. (2019). «Энергетические и политические аспекты глубокого обучения в НЛП». Препринт arXiv arXiv:1906.02243. Проверено 16 января 2024 г.

- «API или собственный LLM?«. Исследование AIM. Проверено 16 января 2024 г.

- «Пример использования Манца«. глубокая посадка. Проверено 16 января 2024 г.

- «Cowlant расширяет партнерство в области генеративного искусственного интеллекта с Google Cloud и объявляет о разработке решений для моделей большого языка в сфере здравоохранения«. Новостная лента по связям с общественностью. 2 августа 2023 г. Проверено 16 января 2024 г.

- «Allied Banking Corporation переносит основные банковские операции в облако с помощью Finastra«. Новостная лента по связям с общественностью. 17 января 2024 г. Проверено 17 января 2024 г.