Амазонка Аптека — это аптека полного цикла Amazon.com который предлагает прозрачные цены, клиническую и клиентскую поддержку, а также бесплатную доставку прямо к вашей двери. Агенты по обслуживанию клиентов играют решающую роль в быстром и точном получении информации, связанной с аптечной информацией, включая разъяснения по рецептам и статус передачи, детали заказа и выдачи, а также информацию о профиле пациента, в режиме реального времени. Amazon Pharmacy предоставляет интерфейс чата, где клиенты (пациенты и врачи) могут общаться онлайн с представителями службы поддержки клиентов (агентами). Одна из проблем, с которой сталкиваются агенты, — это поиск точной информации при ответе на вопросы клиентов, поскольку разнообразие, объем и сложность процессов здравоохранения (например, объяснение предварительных разрешений) могут быть устрашающими. Поиск нужной информации, ее обобщение и объяснение требуют времени, замедляя скорость обслуживания пациентов.

Чтобы решить эту проблему, Amazon Pharmacy создала генеративный ИИ-помощник по вопросам и ответам (Q&A), который позволяет агентам получать информацию с помощью поиска на естественном языке в режиме реального времени, сохраняя при этом человеческое взаимодействие с клиентами. Решение соответствует требованиям HIPAA, обеспечивая конфиденциальность клиентов. Кроме того, агенты отправляют свои отзывы, связанные с автоматическими ответами, команде разработчиков Amazon Pharmacy, чтобы их можно было использовать для будущих улучшений модели.

В этом посте мы описываем, как компания Amazon Pharmacy реализовала свое решение чат-бота-помощника агента по обслуживанию клиентов с использованием продуктов AWS AI, включая базовые модели в Amazon SageMaker JumpStart, чтобы ускорить разработку. Мы начнем с описания общего опыта работы агента по обслуживанию клиентов с добавления чат-бота на основе большой языковой модели (LLM). Затем мы объясним, как решение использует шаблон расширенной генерации (RAG) для своей реализации. Наконец, мы опишем архитектуру продукта. В этом посте показано, как генеративный искусственный интеллект интегрируется в уже работающее приложение в сложном и строго регулируемом бизнесе, улучшая качество обслуживания пациентов аптек.

Чат-бот вопросов и ответов на базе LLM

На следующем рисунке показан процесс обращения пациента в службу поддержки клиентов Amazon Pharmacy через чат (шаг 1). Агенты используют отдельный внутренний пользовательский интерфейс службы поддержки клиентов, чтобы задавать вопросы чат-боту вопросов и ответов на базе LLM (шаг 2). Затем пользовательский интерфейс службы поддержки клиентов отправляет запрос на серверную часть сервиса, размещенную на AWS Fargate (шаг 3), где запросы координируются с помощью комбинации моделей и процессов получения данных, известных под общим названием процесс RAG. Этот процесс является основой решения чат-бота на основе LLM, и его детали описаны в следующем разделе. В конце этого процесса сгенерированный машиной ответ возвращается агенту, который может просмотреть ответ, прежде чем вернуть его конечному клиенту (шаг 4). Следует отметить, что агенты обучены проявлять рассудительность и использовать решение чат-бота на основе LLM в качестве инструмента, который дополняет их работу, поэтому они могут посвятить свое время личному взаимодействию с клиентом. Агенты также помечают сгенерированный машиной ответ своими отзывами (например, положительными или отрицательными). Эта обратная связь затем используется командой разработчиков Amazon Pharmacy для улучшения решения (путем тонкой настройки или улучшения данных), образуя непрерывный цикл разработки продукта вместе с пользователем (шаг 5).

На следующем рисунке показан пример взаимодействия чат-бота вопросов и ответов с агентом. Здесь агент спрашивал о коде отклонения претензии. Чат-бот «Вопросы и ответы» (Agent AI Assistant) отвечает на вопрос с четким описанием кода отказа. Он также предоставляет ссылку на исходную документацию, которую агенты могут использовать при необходимости.

Ускорение разработки модели машинного обучения

На предыдущем рисунке, изображающем рабочий процесс чат-бота, мы пропустили детали обучения начальной версии моделей чат-бота с вопросами и ответами. Для этого команда разработчиков Amazon Pharmacy воспользовалась SageMaker JumpStart. SageMaker JumpStart позволил команде быстро экспериментировать с различными моделями, запускать различные тесты и тесты, быстро теряя неудачу при необходимости. Быстро терпит неудачу — это концепция, которую практикуют учёные и разработчики, чтобы быстро создавать максимально реалистичные решения и учиться на своих усилиях улучшать их в следующей итерации. После того, как команда определилась с моделью и выполнила всю необходимую тонкую настройку и настройку, они использовали хостинг SageMaker для развертывания решения. Повторное использование базовых моделей в SageMaker JumpStart позволило команде разработчиков сократить месяцы работы, которые в противном случае потребовались бы для обучения моделей с нуля.

Шаблон проектирования RAG

Одной из основных частей решения является использование Поисковая расширенная генерация (RAG) шаблон проектирования для реализации решений вопросов и ответов. Первым шагом в этом шаблоне является определение набора известных пар вопросов и ответов, которые являются исходной истиной для решения. Следующим шагом является преобразование вопросов в лучшее представление с целью сходства и поиска, что называется встраивание (мы встраиваем объект более высокой размерности в гиперплоскость с меньшими размерами). Это делается с помощью встроенной базовой модели. Эти внедрения используются в качестве индексов ответов, подобно тому, как индекс базы данных сопоставляет первичный ключ со строкой. Теперь мы готовы поддерживать новые запросы, поступающие от клиентов. Как объяснялось ранее, опыт заключается в том, что клиенты отправляют свои запросы агентам, которые затем взаимодействуют с чат-ботом на основе LLM. В чат-боте вопросов и ответов запрос преобразуется во встраивание, а затем используется в качестве ключа поиска для соответствующего индекса (из предыдущего шага). Критерии соответствия основаны на модели сходства, такой как ФАИСС или Amazon Open Search Service (более подробную информацию см. в описании возможностей базы данных векторов Amazon OpenSearch Service). При наличии совпадений наиболее популярные ответы извлекаются и используются в качестве контекста подсказки для генеративной модели. Это соответствует второму шагу шаблона RAG — генеративному шагу. На этом этапе запрос отправляется в LLM (модальное окно генератора), которое составляет окончательный автоматический ответ на исходный вопрос. Этот ответ возвращается через пользовательский интерфейс службы поддержки клиентов агенту, который проверяет ответ, при необходимости редактирует его и отправляет обратно пациенту. Следующая диаграмма иллюстрирует этот процесс.

Управление базой знаний

Как мы узнали из шаблона RAG, первый шаг в выполнении вопросов и ответов состоит из получения данных (пар вопросов и ответов), которые будут использоваться в качестве контекста для приглашения LLM. Эти данные называются данными чат-бота. база знаний. Примерами этих данных являются внутренние стандартные операционные процедуры (СОП) Amazon Pharmacy и информация, доступная в Справочный центр аптек Amazon. Чтобы облегчить процесс индексации и поиска (как описано ранее), часто бывает полезно собрать всю эту информацию, которая может храниться в различных решениях, например, в вики, файлах и базах данных, в одном репозитории. В конкретном случае с чат-ботом Amazon Pharmacy мы используем для этой цели Amazon Simple Storage Service (Amazon S3) из-за его простоты и гибкости.

Обзор решения

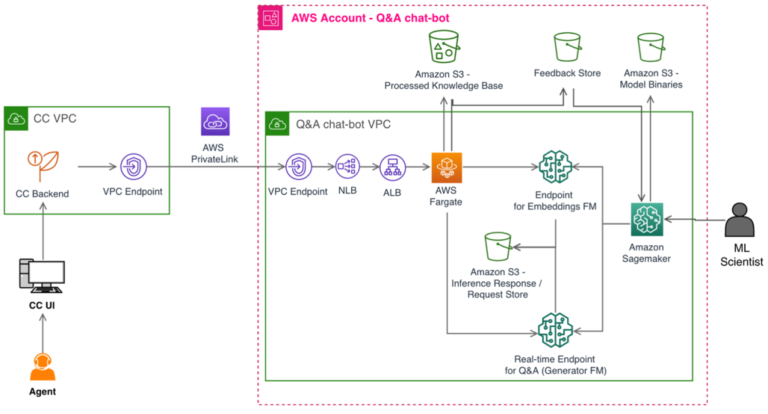

На следующем рисунке показана архитектура решения. Приложение для обслуживания клиентов и чат-бот вопросов и ответов на базе LLM развертываются в собственном VPC для сетевой изоляции. Соединение между конечными точками VPC реализуется через AWS PrivateLink, гарантируя их конфиденциальность. Чат-бот «Вопросы и ответы» также имеет собственную учетную запись AWS для разделения ролей, изоляции и простоты мониторинга в целях безопасности, снижения затрат и соблюдения требований. Логика оркестрации чат-бота вопросов и ответов размещается в Fargate с помощью Amazon Elastic Container Service (Amazon ECS). Чтобы настроить PrivateLink, балансировщик сетевой нагрузки передает запросы в балансировщик нагрузки приложений, который останавливает TLS-соединение конечного клиента и передает запросы в Fargate. Основным хранилищем является Amazon S3. Как упоминалось ранее, соответствующие входные данные импортируются в нужный формат в учетную запись чат-бота вопросов и ответов и сохраняются в корзинах S3.

Когда дело доходит до инфраструктуры машинного обучения (ML), Amazon SageMaker находится в центре архитектуры. Как объяснялось в предыдущих разделах, используются две модели: модель внедрения и модель LLM, которые размещаются в двух отдельных конечных точках SageMaker. Используя функцию сбора данных SageMaker, мы можем регистрировать все запросы и ответы на выводы для целей устранения неполадок с соблюдением необходимых ограничений конфиденциальности и безопасности. Далее отзывы, полученные от агентов, сохраняются в отдельной корзине S3.

Чат-бот «Вопросы и ответы» представляет собой многопользовательское решение и поддерживает дополнительные продукты здравоохранения от Amazon Health Services, такие как Amazon Clinic. Например, решение развертывается с помощью шаблонов AWS CloudFormation для инфраструктуры как кода (IaC), что позволяет использовать различные базы знаний.

Заключение

В этом посте было представлено техническое решение для улучшения обслуживания клиентов с помощью генеративного искусственного интеллекта Amazon Pharmacy. Решение состоит из чат-бота, отвечающего на вопросы, реализующего шаблон проектирования RAG в SageMaker и базовых моделей в SageMaker JumpStart. Благодаря этому решению агенты по обслуживанию клиентов могут быстрее помогать пациентам, предоставляя при этом точные, информативные и краткие ответы.

В архитектуре используются модульные микросервисы с отдельными компонентами для подготовки и загрузки базы знаний, логики чат-бота (инструкций), встроенной индексации и поиска, генерации контента LLM и контроля обратной связи. Последнее особенно важно для постоянного улучшения модели. Базовые модели в SageMaker JumpStart используются для быстрого экспериментирования с обслуживанием моделей с помощью конечных точек SageMaker. Наконец, сервер чат-бота, соответствующий требованиям HIPAA, размещен на Fargate.

Подводя итог, мы увидели, как Amazon Pharmacy использует генеративный искусственный интеллект и AWS для улучшения обслуживания клиентов, уделяя при этом приоритетное внимание принципам и практикам ответственного ИИ.

Вы можете начать экспериментировать с базовыми моделями в SageMaker JumpStart уже сегодня, чтобы найти подходящие базовые модели для вашего варианта использования и начать создавать генеративное приложение ИИ на SageMaker.

Об авторе

Бурак Гозлуклу — главный специалист по архитектуре решений AI/ML в Бостоне, Массачусетс. Он помогает клиентам по всему миру внедрять технологии AWS и, в частности, решения AI/ML для достижения своих бизнес-целей. Бурак имеет докторскую степень в области аэрокосмической техники в METU, степень магистра в области системной инженерии и постдок по системной динамике в Массачусетском технологическом институте в Кембридже, штат Массачусетс. Бурак увлечен йогой и медитацией.

Бурак Гозлуклу — главный специалист по архитектуре решений AI/ML в Бостоне, Массачусетс. Он помогает клиентам по всему миру внедрять технологии AWS и, в частности, решения AI/ML для достижения своих бизнес-целей. Бурак имеет докторскую степень в области аэрокосмической техники в METU, степень магистра в области системной инженерии и постдок по системной динамике в Массачусетском технологическом институте в Кембридже, штат Массачусетс. Бурак увлечен йогой и медитацией.

Чангвон Ким — старший научный сотрудник Amazon Health Store & Tech. У него есть опыт в области LLM, НЛП, речевого искусственного интеллекта и поиска. До прихода в Amazon Health Чанвон работал учёным-прикладником в Amazon Alexa Speech. Он базируется в Лос-Анджелесе.

Чангвон Ким — старший научный сотрудник Amazon Health Store & Tech. У него есть опыт в области LLM, НЛП, речевого искусственного интеллекта и поиска. До прихода в Amazon Health Чанвон работал учёным-прикладником в Amazon Alexa Speech. Он базируется в Лос-Анджелесе.

Александр Алвес — старший главный инженер в Amazon Health Services, специализирующийся на машинном обучении, оптимизации и распределенных системах. Он помогает обеспечить хорошее здоровье.

Александр Алвес — старший главный инженер в Amazon Health Services, специализирующийся на машинном обучении, оптимизации и распределенных системах. Он помогает обеспечить хорошее здоровье.

Нирвай Кумар — старший инженер по разработке программного обеспечения в Amazon Health Services, ведущий специалист по архитектуре в отделе фармацевтических операций после многих лет работы в Fulfillment Technologies. Имея опыт работы в распределенных системах, он все больше увлекается потенциалом искусственного интеллекта. Нирвай направляет свои таланты на разработку инженерных систем, которые решают реальные потребности клиентов с креативностью, заботой, безопасностью и долгосрочным видением. Когда он не путешествует по горам Вашингтона, он сосредотачивается на продуманном дизайне, предвосхищающем неожиданности. Nirvay стремится создавать системы, которые выдерживают испытание временем и удовлетворяют меняющиеся потребности клиентов.

Нирвай Кумар — старший инженер по разработке программного обеспечения в Amazon Health Services, ведущий специалист по архитектуре в отделе фармацевтических операций после многих лет работы в Fulfillment Technologies. Имея опыт работы в распределенных системах, он все больше увлекается потенциалом искусственного интеллекта. Нирвай направляет свои таланты на разработку инженерных систем, которые решают реальные потребности клиентов с креативностью, заботой, безопасностью и долгосрочным видением. Когда он не путешествует по горам Вашингтона, он сосредотачивается на продуманном дизайне, предвосхищающем неожиданности. Nirvay стремится создавать системы, которые выдерживают испытание временем и удовлетворяют меняющиеся потребности клиентов.