Этот пост написан в соавторстве с Иланом Геллером и Шую Ян из Accenture.

Сегодня предприятия сталкиваются с серьезными проблемами, когда дело доходит до использования своей информации и баз знаний как для внутренних, так и для внешних бизнес-операций. В условиях постоянно меняющихся операций, процессов, политик и требований соответствия сотрудникам и клиентам может быть чрезвычайно сложно оставаться в курсе событий. В то же время неструктурированный характер большей части этого контента приводит к тому, что поиск ответов с помощью традиционного поиска занимает много времени.

Внутри компании сотрудники часто могут тратить бесчисленные часы на поиск информации, необходимой им для выполнения своей работы, что приводит к разочарованию и снижению производительности. А когда они не могут найти ответы, им приходится обострять проблемы или принимать решения без полного контекста, что может создать риск.

Внешне клиенты также могут испытывать трудности с поиском информации, которую они ищут. Хотя корпоративные базы знаний со временем улучшили качество обслуживания клиентов, они все еще могут быть громоздкими и сложными в использовании. Независимо от того, ищете ли вы ответы на вопросы, связанные с продуктом, или вам нужна информация о часах работы и местоположении, плохой опыт может привести к разочарованию или, что еще хуже, к отказу клиента.

В любом случае, поскольку управление знаниями становится более сложным, генеративный ИИ предоставляет предприятиям революционную возможность подключать людей к информации, необходимой им для работы и инноваций. При правильной стратегии эти интеллектуальные решения могут изменить способы сбора, организации и использования знаний в организации.

Чтобы помочь решить эту проблему, Accenture в сотрудничестве с AWS создала инновационное решение для генеративного искусственного интеллекта под названием Knowledge Assist. Используя сервисы генеративного искусственного интеллекта AWS, команда разработала систему, которая может принимать и обрабатывать огромные объемы неструктурированного корпоративного контента.

Вместо традиционного поиска по ключевым словам пользователи теперь могут задавать вопросы и получать точные ответы в простом диалоговом интерфейсе. Генеративный ИИ понимает контекст и взаимосвязи в базе знаний, чтобы предоставлять персонализированные и точные ответы. По мере того, как система обрабатывает больше запросов, она постоянно совершенствует языковую обработку с помощью алгоритмов машинного обучения (ML).

С момента запуска этой системы поддержки искусственного интеллекта компании добились значительного улучшения в сохранении знаний и производительности сотрудников. Обеспечивая быстрый и точный доступ к информации и предоставляя сотрудникам возможность самообслуживания, это решение сокращает время обучения новых сотрудников более чем на 50 % и сокращает необходимость эскалации до 40 %.

Благодаря возможностям генеративного искусственного интеллекта предприятия могут изменить способы сбора, организации и распространения знаний в рамках организации. Раскрывая существующие базы знаний, компании могут повысить производительность сотрудников и удовлетворенность клиентов. Как показывает сотрудничество Accenture с AWS, будущее управления корпоративными знаниями лежит в системах на базе искусственного интеллекта, которые развиваются за счет взаимодействия между людьми и машинами.

Accenture сотрудничает с AWS, чтобы помочь клиентам развернуть Amazon Bedrock, использовать самые передовые базовые модели, такие как Amazon Titan, и внедрить ведущие в отрасли технологии, такие как Amazon SageMaker JumpStart и Amazon Inferentia, наряду с другими сервисами AWS ML.

В этом посте представлен обзор комплексного генеративного решения искусственного интеллекта, разработанного Accenture для производственного сценария использования Amazon Bedrock и других сервисов AWS.

Обзор решения

Крупный клиент из сектора общественного здравоохранения ежедневно обслуживает миллионы граждан, и им требуется легкий доступ к актуальной информации в постоянно меняющейся ситуации в сфере здравоохранения. Accenture интегрировала эту генеративную функцию искусственного интеллекта в существующего бота для часто задаваемых вопросов, что позволяет чат-боту давать ответы на более широкий спектр вопросов пользователей. Расширение возможностей граждан получать доступ к соответствующей информации в режиме самообслуживания экономит время и деньги отдела, уменьшая необходимость взаимодействия с оператором колл-центра. Ключевые особенности решения включают в себя:

- Гибридный подход намерений – Использует генеративные и предварительно обученные намерения

- Многоязычная поддержка — Разговаривает на английском и испанском языках.

- Разговорный анализ – Отчеты о потребностях, настроениях и проблемах пользователей.

- Естественные разговоры – Поддерживает контекст с помощью обработки естественного языка (NLP), подобной человеческому.

- Прозрачные цитаты – Направляет пользователей к исходной информации.

Генеративное решение Accenture на основе искусственного интеллекта обеспечивает следующие преимущества по сравнению с существующими или традиционными платформами чат-ботов:

- Быстро генерирует точные, релевантные и естественно звучащие ответы на запросы пользователей.

- Помнит контекст и отвечает на дополнительные вопросы.

- Обрабатывает запросы и генерирует ответы на нескольких языках (например, английском и испанском).

- Постоянно учится и совершенствует ответы на основе отзывов пользователей.

- Легко интегрируется с существующей веб-платформой.

- Поглощает обширный репозиторий базы знаний предприятия.

- Реагирует по-человечески

- Развитие знаний постоянно доступно с минимальными усилиями или вообще без них.

- Использует модель оплаты по мере использования без первоначальных затрат.

Высокоуровневый рабочий процесс этого решения включает в себя следующие шаги:

- Пользователи создают простую интеграцию с существующими веб-платформами.

- Данные загружаются на платформу в виде массовой загрузки в день 0, а затем в виде добавочной загрузки в день 1+.

- Запросы пользователей обрабатываются в режиме реального времени с масштабированием системы по мере необходимости для удовлетворения потребностей пользователей.

- Разговоры сохраняются в базах данных приложений (Amazon Dynamo DB) для поддержки многораундовых разговоров.

- Модель фонда Anthropic Claude запускается через Amazon Bedrock, который используется для генерации ответов на запросы на основе наиболее релевантного контента.

- Модель Anthropic Claude Foundation используется для перевода запросов и ответов с английского на другие нужные языки для поддержки многоязычного общения.

- Модель Amazon Titan Foundation вызывается через Amazon Bedrock для создания векторных вложений.

- Релевантность контента определяется посредством сходства встраивания необработанного контента и встраивания пользовательского запроса с использованием встраивания векторной базы данных Pinecone.

- Контекст вместе с вопросом пользователя добавляется для создания подсказки, которая предоставляется в качестве входных данных для модели Anthropic Claude. Сгенерированный ответ возвращается пользователю через веб-платформу.

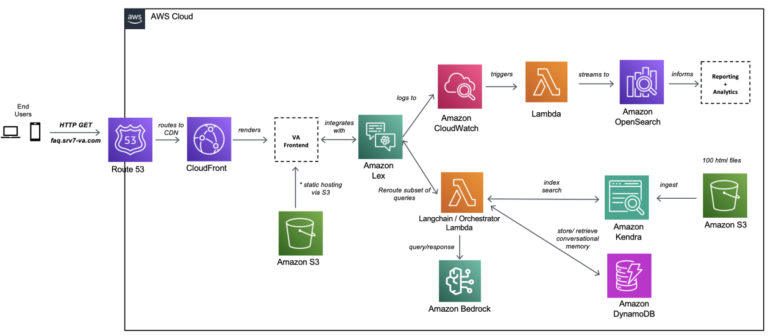

На следующей диаграмме показана архитектура решения.

Архитектурный поток можно разделить на две части:

В следующих разделах мы более подробно обсудим различные аспекты решения и его развитие.

Выбор модели

Процесс выбора модели включал регрессионное тестирование различных моделей, доступных в Amazon Bedrock, включая модели AI21 Labs, Cohere, Anthropic и Amazon Foundation. Мы проверили поддерживаемые варианты использования, атрибуты модели, максимальное количество токенов, стоимость, точность, производительность и языки. Исходя из этого, мы выбрали Claude-2 как наиболее подходящий для данного варианта использования.

Источник данных

Мы создали индекс Amazon Kendra и добавили источник данных с помощью коннекторов веб-сканера с корневым URL-адресом веб-страницы и глубиной каталога двух уровней. Несколько веб-страниц были добавлены в индекс Amazon Kendra и использованы в качестве источника данных.

Процесс запроса и ответа чат-бота GenAI

Шаги этого процесса состоят из сквозного взаимодействия с запросом от Amazon Lex и ответа от большой языковой модели (LLM):

- Пользователь отправляет запрос диалоговому интерфейсному приложению, размещенному в корзине Amazon Simple Storage Service (Amazon S3), через Amazon Route 53 и Amazon CloudFront.

- Amazon Lex понимает намерение и направляет запрос оркестратору, размещенному в функции AWS Lambda.

- Функция оркестратора Lambda выполняет следующие шаги:

- Функция взаимодействует с базой данных приложения, которая размещается в базе данных, управляемой DynamoDB. В базе данных хранятся идентификатор сеанса и идентификатор пользователя для истории разговоров.

- Другой запрос отправляется в индекс Amazon Kendra, чтобы получить пять лучших релевантных результатов поиска для создания соответствующего контекста. Используя этот контекст, создается измененное приглашение, необходимое для модели LLM.

- Соединение устанавливается между Amazon Bedrock и оркестратором. В модель Amazon Bedrock Claude-2 отправляется запрос, чтобы получить ответ от выбранной модели LLM.

- Данные из ответа LLM подвергаются постобработке, и ответ отправляется пользователю.

Онлайн отчетность

Процесс онлайн-отчетности состоит из следующих этапов:

- Конечные пользователи взаимодействуют с чат-ботом через внешний уровень CloudFront CDN.

- Каждое взаимодействие запроса/ответа обеспечивается AWS SDK и отправляет сетевой трафик в Amazon Lex (компонент NLP бота).

- Метаданные о парах запрос/ответ регистрируются в Amazon CloudWatch.

- Группа журналов CloudWatch настроена с фильтром подписки, который отправляет журналы в Amazon OpenSearch Service.

- После того, как журналы станут доступны в OpenSearch Service, их можно будет использовать для создания отчетов и информационных панелей с помощью Kibana.

Заключение

В этом посте мы продемонстрировали, как Accenture использует генеративные сервисы искусственного интеллекта AWS для реализации комплексного подхода к цифровой трансформации. Мы выявили пробелы в традиционных платформах ответов на вопросы и расширили генеративный интеллект в их рамках для более быстрого реагирования и постоянного улучшения системы, одновременно взаимодействуя с пользователями по всему миру. Обратитесь к команде Центра передового опыта Accenture, чтобы глубже изучить решение и развернуть его для своих клиентов.

Эту платформу Knowledge Assist можно применять в различных отраслях, включая, помимо прочего, здравоохранение, финансовые услуги, производство и многое другое. Эта платформа обеспечивает естественные, человеческие ответы на вопросы, используя проверенные знания. Эта платформа обеспечивает эффективность, производительность и более точные действия для пользователей.

Совместные усилия основаны на 15-летних стратегических отношениях между компаниями и используют те же проверенные механизмы и ускорители, созданные бизнес-группой Accenture AWS (AABG).

Свяжитесь с командой AABG по адресу Accentureaws@amazon.com для достижения бизнес-результатов путем преобразования в интеллектуальное предприятие по работе с данными на AWS.

Для получения дополнительной информации о генеративном искусственном интеллекте в AWS с использованием Amazon Bedrock или Amazon SageMaker мы рекомендуем следующие ресурсы:

Вы также можете подпишитесь на информационный бюллетень AWS о генеративном искусственном интеллектекоторый включает образовательные ресурсы, блоги и обновления служб.

Об авторах

Илан Геллер — управляющий директор Accenture, специализирующийся на искусственном интеллекте, помогающий клиентам масштабировать приложения искусственного интеллекта, а также руководитель глобального партнера GenAI COE для AWS.

Илан Геллер — управляющий директор Accenture, специализирующийся на искусственном интеллекте, помогающий клиентам масштабировать приложения искусственного интеллекта, а также руководитель глобального партнера GenAI COE для AWS.

Шую Ян является руководителем отдела генеративного искусственного интеллекта и разработки больших языковых моделей, а также возглавляет группы CoE (Центр передового опыта) Accenture AI (профессиональные специалисты AWS DevOps).

Шую Ян является руководителем отдела генеративного искусственного интеллекта и разработки больших языковых моделей, а также возглавляет группы CoE (Центр передового опыта) Accenture AI (профессиональные специалисты AWS DevOps).

Шикхар Кватра — специалист по архитектуре решений AI/ML в Amazon Web Services, работающий с ведущим глобальным системным интегратором. Он заслужил звание одного из самых молодых индийских мастеров-изобретателей, получив более 500 патентов в областях искусственного интеллекта, машинного обучения и Интернета вещей. Шикхар помогает в проектировании, создании и обслуживании экономичных масштабируемых облачных сред для организации, а также поддерживает партнера GSI в создании стратегических отраслевых решений на AWS.

Шикхар Кватра — специалист по архитектуре решений AI/ML в Amazon Web Services, работающий с ведущим глобальным системным интегратором. Он заслужил звание одного из самых молодых индийских мастеров-изобретателей, получив более 500 патентов в областях искусственного интеллекта, машинного обучения и Интернета вещей. Шикхар помогает в проектировании, создании и обслуживании экономичных масштабируемых облачных сред для организации, а также поддерживает партнера GSI в создании стратегических отраслевых решений на AWS.

Джей Пиллаи — главный архитектор решений в Amazon Web Services. В этой должности он является ведущим архитектором глобального генеративного искусственного интеллекта, а также ведущим архитектором решений для цепочек поставок в AABG. Как руководитель информационных технологий Джей специализируется на искусственном интеллекте, интеграции данных, бизнес-аналитике и пользовательском интерфейсе. Он имеет 23-летний обширный опыт работы с несколькими клиентами в сферах цепочки поставок, юридических технологий, недвижимости, финансовых услуг, страхования, платежей и исследований рынка.

Джей Пиллаи — главный архитектор решений в Amazon Web Services. В этой должности он является ведущим архитектором глобального генеративного искусственного интеллекта, а также ведущим архитектором решений для цепочек поставок в AABG. Как руководитель информационных технологий Джей специализируется на искусственном интеллекте, интеграции данных, бизнес-аналитике и пользовательском интерфейсе. Он имеет 23-летний обширный опыт работы с несколькими клиентами в сферах цепочки поставок, юридических технологий, недвижимости, финансовых услуг, страхования, платежей и исследований рынка.

Картик Сонти возглавляет глобальную команду архитекторов решений, которая занимается концептуализацией, созданием и запуском горизонтальных, функциональных и вертикальных решений совместно с Accenture, чтобы помочь нашим общим клиентам дифференцированно трансформировать свой бизнес на AWS.

Картик Сонти возглавляет глобальную команду архитекторов решений, которая занимается концептуализацией, созданием и запуском горизонтальных, функциональных и вертикальных решений совместно с Accenture, чтобы помочь нашим общим клиентам дифференцированно трансформировать свой бизнес на AWS.