Способность привязывать язык к видению является фундаментальным аспектом реальных систем искусственного интеллекта; это полезно для решения ряда задач (напримервизуальный ответ на вопрос) и приложений (например, создание описаний для слабовидящих). Мультимодальные модели (предварительно обученные на парах «язык-изображение») направлены на решение этой проблемы заземления. Недавнее семейство моделей, мультимодальные преобразователи (например, Lu et al., 2019; Chen et al., 2020; Tan and Bansal, 2019; Li et al., 2020), достигли самых современных результатов в ряд мультимодальных тестов, предполагающих, что архитектура преобразователя совместного кодирования лучше подходит для захвата выравнивания между парами изображения и языка, чем предыдущие подходы (например, двойные кодировщики).

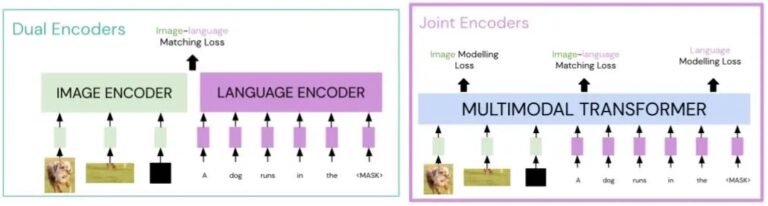

В частности, по сравнению с архитектурой с двумя кодировщиками, в которой нет перекрестных помех между модальностями, мультимодальные преобразователи (совместные кодировщики) более эффективны для выборки. На приведенном ниже графике мы видим, что при тестировании извлечения нулевого кадра существующий мультимодальный преобразователь (UNITER) работает аналогично крупномасштабному двойному кодировщику (CLIP), который обучается на в 100 раз больше данных.

В этой работе мы исследуем, какие аспекты мультимодальных преобразователей — внимание, потери и данные предварительной подготовки — важны для их успеха при мультимодальной предварительной подготовке. Мы находим, что мультимодальное внимание, когда трансформеры языка и изображения взаимодействуют друг с другом, имеет решающее значение для успеха этих моделей. Модели с другими типами внимания (даже с большей глубиной или параметрами) не достигают результатов, сравнимых с более поверхностными и меньшими моделями с мультимодальным вниманием. Более того, сравнимые результаты могут быть получены без потери изображения (моделирование маскированной области), изначально предложенной для мультимодальных трансформаторов. Это говорит о том, что наши нынешние модели не используют полезный сигнал в модальности изображения, предположительно из-за формулировки потери изображения.

Мы также изучаем различные свойства мультимодальных наборов данных, такие как их размер и степень, в которой язык описывает соответствующее изображение (зашумленность). Мы обнаружили, что размер набора данных не всегда предсказывает производительность мультимодальных преобразователей; его уровень шума и языковое сходство с задачей оценки являются важными факторами. Это говорит о важности курирования менее зашумленных наборов данных изображения и текста, несмотря на текущую тенденцию сбора зашумленных наборов данных из Интернета.

В целом, наш анализ показывает, что мультимодальные преобразователи сильнее, чем архитектура с двойным кодировщиком (при том же объеме данных предварительной подготовки), в основном из-за перекрестных помех при мультимодальном внимании. Тем не менее, при разработке мультимодальных моделей все еще остается много открытых проблем, в том числе лучшие потери для модальности изображения и устойчивость к шуму набора данных.