Этот пост написан в соавторстве с Шервином Чу из Алиды.

Алида помогает крупнейшим мировым брендам создавать активные исследовательские сообщества для сбора отзывов, которые способствуют улучшению качества обслуживания клиентов и инновациям в продуктах.

Клиенты Alida получают десятки тысяч заинтересованных ответов на один опрос, поэтому команда Alida решила использовать машинное обучение (ML) для обслуживания своих клиентов в широком масштабе. Однако при использовании традиционных моделей обработки естественного языка (НЛП) они обнаружили, что эти решения с трудом могут полностью понять нюансы обратной связи, обнаруженные в открытых ответах на опросы. Модели часто отражали лишь поверхностные темы и настроения и упускали важный контекст, который позволил бы получить более точную и значимую информацию.

В этом посте мы узнаем о том, как модель Claude Instant от Anthropic на Amazon Bedrock позволила команде Alida быстро создать масштабируемый сервис, который более точно определяет тему и настроения в рамках сложных ответов на опросы. Новый сервис добился улучшения утверждения тем в 4–6 раз за счет тесной кластеризации по нескольким десяткам ключевых тем вместо сотен шумных ключевых слов НЛП.

Amazon Bedrock — это полностью управляемый сервис, который предлагает выбор высокопроизводительных базовых моделей (FM) от ведущих компаний в области искусственного интеллекта, таких как AI21 Labs, Anthropic, Cohere, Meta, Stability AI и Amazon, через единый API, а также широкую набор возможностей, необходимых для создания генеративных приложений ИИ с безопасностью, конфиденциальностью и ответственным ИИ.

Использование Amazon Bedrock позволило Alida вывести свои услуги на рынок быстрее, чем если бы они обращались к другим поставщикам или поставщикам машинного обучения (ML).

Соревнование

Опросы с сочетанием вопросов с несколькими вариантами ответов и открытых вопросов позволяют исследователям рынка получить более целостное представление, собирая как количественные, так и качественные данные.

Вопросы с несколькими вариантами ответов легко анализировать в масштабе, но им не хватает нюансов и глубины. Установление вариантов ответа также может привести к предвзятости или предвзятости в ответах участников.

Открытые вопросы опроса позволяют респондентам предоставить контекст и непредвиденную обратную связь. Эти качественные данные углубляют понимание исследователей за пределами того, что могут дать вопросы с несколькими вариантами ответов в одиночку. Проблема с текстом в свободной форме заключается в том, что он может привести к сложным и тонким ответам, которые трудно полностью понять традиционному НЛП. Например:

«Недавно я испытал некоторые жизненные трудности и был очень расстроен и разочарован. Когда я приходил, персонал всегда был очень добр ко мне. Это помогло мне пережить трудные времена!»

Традиционные методы НЛП определяют темы как «трудности», «разочарования», «добрый персонал» и «пережить трудные времена». Он не может отличить общий текущий негативный жизненный опыт респондента от конкретного положительного опыта накопления.

Существующее решение Алиды автоматически обрабатывает большие объемы открытых ответов, но они хотели, чтобы их клиенты лучше понимали контекст и могли делать выводы по теме на высоком уровне.

Амазонка

До внедрения программ LLM для Alida целью улучшения существующего одномодельного решения было тесное сотрудничество с отраслевыми экспертами, а также разработка, обучение и совершенствование новых моделей специально для каждой из отраслевых вертикалей, в которых работали клиенты Alida. Это было трудоемким и дорогостоящим мероприятием.

Одним из прорывов, которые делают LLM таким мощным, является использование механизмов внимания. LLM используют механизмы самообслуживания, которые анализируют отношения между словами в заданной подсказке. Это позволяет специалистам LLM лучше справляться с темой и настроениями из предыдущего примера и представляет интересную новую технологию, которую можно использовать для решения этой проблемы.

С помощью Amazon Bedrock команды и отдельные лица могут сразу же начать использовать базовые модели, не беспокоясь о предоставлении инфраструктуры или настройке и настройке платформ машинного обучения. Вы можете начать работу со следующих шагов:

- Убедитесь, что у вашего пользователя или роли есть разрешение на создание или изменение ресурсов Amazon Bedrock. Подробности см. в разделе «Примеры политик на основе удостоверений для Amazon Bedrock».

- Войдите в консоль Amazon Bedrock.

- На Доступ к модели просмотрите лицензионное соглашение и включите FM, которые вы хотите использовать в своей учетной записи.

- Начните взаимодействовать с FM следующими способами:

Высшее руководство Alida стремилось стать одним из первых, кто внедрит Amazon Bedrock, поскольку осознавало его способность помогать своим командам быстрее выводить на рынок новые генеративные решения на базе искусственного интеллекта.

Винси Уильям, старший технический директор компании Alida, возглавляющий команду, отвечающую за создание службы анализа тем и настроений, говорит:

«LLM обеспечивают большой скачок в качественном анализе и делают то, что (в таких масштабах) невозможно сделать по-человечески. Amazon Bedrock меняет правила игры, позволяя нам использовать LLM без каких-либо сложностей».

Команда инженеров сразу же почувствовала легкость начала работы с Amazon Bedrock. Они могли выбирать из различных базовых моделей и сосредоточиться на оперативном проектировании, а не тратить время на подбор правильного размера, выделение ресурсов, развертывание и настройку ресурсов для запуска моделей.

Обзор решения

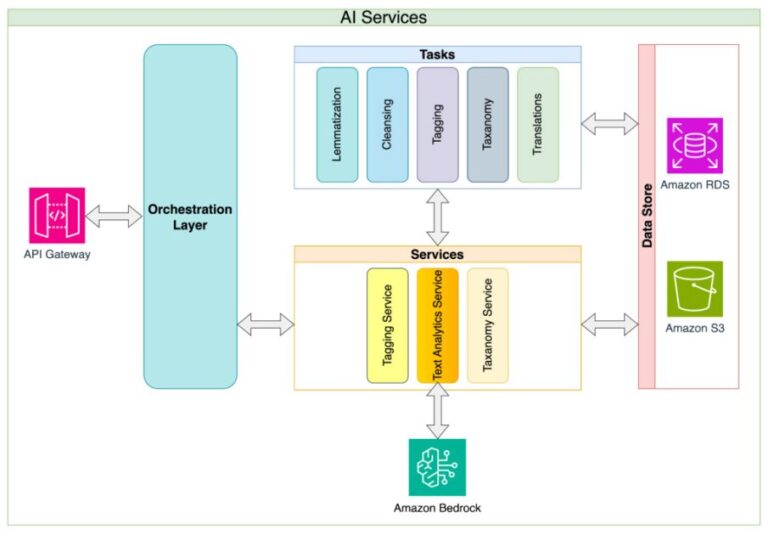

Шервин Чу, главный архитектор Alida, поделился подходом Alida к архитектуре микросервисов. Алида создала классификацию тем и настроений как услугу, в качестве первого приложения которой был использован анализ ответов на опросы. Благодаря такому подходу общие проблемы реализации LLM, такие как сложность управления подсказками, ограничениями токенов, ограничениями запросов и повторными попытками, абстрагируются, а решение позволяет потребляющим приложениям иметь простой и стабильный API для работы. Этот подход на уровне абстракции также позволяет владельцам сервисов постоянно улучшать детали внутренней реализации и минимизировать изменения, нарушающие API. Наконец, сервисный подход позволяет из одной точки реализовать любые политики управления данными и безопасности, которые развиваются по мере развития управления ИИ в организации.

На следующей диаграмме показаны архитектура и поток решения.

Алида оценила LLM от различных поставщиков и пришла к выводу, что Claude Instant от Anthropic представляет собой правильный баланс между стоимостью и производительностью. Тесно сотрудничая с командой оперативных инженеров, Чу выступал за реализацию стратегии цепочки оперативных сообщений, а не единого монолитного подхода.

Цепочка запросов позволяет выполнять следующие действия:

- Разбейте свою цель на более мелкие и логичные шаги.

- Создайте подсказку для каждого шага

- Последовательно предоставляйте подсказки LLM.

Это создает дополнительные точки контроля, что дает следующие преимущества:

- Систематически оценивать изменения, которые вы вносите в строку ввода, несложно.

- Вы можете реализовать более детальное отслеживание и контроль точности и производительности на каждом этапе.

Ключевые соображения, связанные с этой стратегией, включают увеличение количества запросов к LLM и, как следствие, увеличение общего времени, необходимого для достижения цели. В случае использования Алиды они решили объединить набор открытых ответов в одном запросе на LLM, чтобы компенсировать эти эффекты.

НЛП против LLM

Существующее решение Alida для НЛП основано на алгоритмах кластеризации и статистической классификации для анализа ответов открытых опросов. Применительно к образцам отзывов о мобильном приложении кофейни они извлекали темы на основе шаблонов слов, но не обеспечивали истинного понимания. В следующей таблице приведены некоторые примеры сравнения ответов НЛП и ответов LLM.

| Ответ на опрос | Существующее традиционное НЛП | Amazon Bedrock с Клодом Инстантом | |

| Тема | Тема | Настроение | |

| Я почти исключительно заказываю напитки через приложение из-за удобства, и заказывать супериндивидуальные напитки менее неловко, лол. И я люблю получать награды! | («приложение для удобства», «напиток», «награда») | Удобство мобильного заказа | позитивный |

| Приложение работает довольно хорошо, единственная жалоба, которую я имею, это то, что я не могу добавить любое количество денег на свою подарочную карту. Почему для пополнения счета обязательно должно быть 10 долларов?! | («жалоба», «приложение», «подарочная карта», «цифровые деньги») | Скорость выполнения мобильных заказов | отрицательный |

Результаты примера показывают, как существующее решение смогло извлечь релевантные ключевые слова, но не смогло обеспечить более обобщенное назначение тематической группы.

Напротив, используя Amazon Bedrock и Anthropic Claude Instant, LLM с контекстным обучением может назначать ответы на заранее определенные темы и определять настроения.

Помимо предоставления более качественных ответов для клиентов Алиды, в этом конкретном случае использование решения с использованием LLM вместо традиционных методов НЛП сэкономило огромное количество времени и усилий на обучении и поддержании подходящей модели. В следующей таблице сравнивается обучение традиционной модели НЛП и контекстное обучение LLM.

| . | Требование к данным | Тренировочный процесс | Адаптивность модели |

| Обучение традиционной модели НЛП | Тысячи примеров, помеченных человеком |

Сочетание автоматизированного и ручного проектирования функций. Итеративные циклы обучения и оценки. |

Более медленный цикл обработки из-за необходимости переобучения модели |

| Контекстное обучение LLM | Несколько примеров |

Обучался на лету в рамках подсказки. Ограничено размером контекстного окна. |

Ускорение итераций за счет изменения подсказки. Ограниченное сохранение из-за размера контекстного окна. |

Заключение

Использование Алидой модели Claude Instant от Anthropic на Amazon Bedrock демонстрирует мощные возможности LLM для анализа открытых ответов на опросы. Алиде удалось создать превосходный сервис, который в 4–6 раз точнее проводил тематический анализ по сравнению с их сервисом, основанным на НЛП. Кроме того, использование контекстной оперативной разработки для LLM значительно сократило время разработки, поскольку им не нужно было обрабатывать тысячи точек данных, помеченных человеком, для обучения традиционной модели НЛП. В конечном итоге это позволяет Алиде быстрее предоставлять своим клиентам более полную информацию!

Если вы готовы начать создавать собственную инновационную модель фундамента с помощью Amazon Bedrock, перейдите по этой ссылке, чтобы настроить Amazon Bedrock. Если вам интересно узнать о других интересных приложениях Amazon Bedrock, см. специальный раздел Amazon Bedrock в блоге AWS Machine Learning.

Об авторах

Кинман Лам — архитектор решений ISV/DNB для AWS. У него 17-летний опыт создания и развития технологических компаний в области смартфонов, геолокации, Интернета вещей и программного обеспечения с открытым исходным кодом. В AWS он использует свой опыт, чтобы помогать компаниям создавать надежную инфраструктуру для удовлетворения растущих потребностей растущего бизнеса, запускать новые продукты и услуги, выходить на новые рынки и радовать своих клиентов.

Кинман Лам — архитектор решений ISV/DNB для AWS. У него 17-летний опыт создания и развития технологических компаний в области смартфонов, геолокации, Интернета вещей и программного обеспечения с открытым исходным кодом. В AWS он использует свой опыт, чтобы помогать компаниям создавать надежную инфраструктуру для удовлетворения растущих потребностей растущего бизнеса, запускать новые продукты и услуги, выходить на новые рынки и радовать своих клиентов.

Шервин Чу является главным архитектором в Alida, помогая продуктовым командам с архитектурным направлением, выбором технологий и решением сложных проблем. Он опытный инженер-программист, архитектор и руководитель с более чем 20-летним опытом работы в сфере SaaS для различных отраслей. Он создал и управлял многочисленными системами B2B и B2C на AWS и GCP.

Шервин Чу является главным архитектором в Alida, помогая продуктовым командам с архитектурным направлением, выбором технологий и решением сложных проблем. Он опытный инженер-программист, архитектор и руководитель с более чем 20-летним опытом работы в сфере SaaS для различных отраслей. Он создал и управлял многочисленными системами B2B и B2C на AWS и GCP.

Марк Рой — главный архитектор машинного обучения в AWS, помогающий клиентам проектировать и создавать решения на основе искусственного интеллекта, машинного обучения и генеративного искусственного интеллекта. С начала 2023 года он занимался разработкой архитектуры решений для запуска Amazon Bedrock, флагманского предложения AWS по генеративному искусственному интеллекту для строителей. Работа Марка охватывает широкий спектр вариантов использования, в первую очередь он интересуется генеративным искусственным интеллектом, агентами и масштабированием машинного обучения на предприятии. Он помогал компаниям в сфере страхования, финансовых услуг, средств массовой информации и развлечений, здравоохранения, коммунальных услуг и производства. До прихода в AWS Марк более 25 лет был архитектором, разработчиком и технологическим лидером, в том числе 19 лет в сфере финансовых услуг. Марк имеет шесть сертификатов AWS, включая сертификат ML Specialty Certification.

Марк Рой — главный архитектор машинного обучения в AWS, помогающий клиентам проектировать и создавать решения на основе искусственного интеллекта, машинного обучения и генеративного искусственного интеллекта. С начала 2023 года он занимался разработкой архитектуры решений для запуска Amazon Bedrock, флагманского предложения AWS по генеративному искусственному интеллекту для строителей. Работа Марка охватывает широкий спектр вариантов использования, в первую очередь он интересуется генеративным искусственным интеллектом, агентами и масштабированием машинного обучения на предприятии. Он помогал компаниям в сфере страхования, финансовых услуг, средств массовой информации и развлечений, здравоохранения, коммунальных услуг и производства. До прихода в AWS Марк более 25 лет был архитектором, разработчиком и технологическим лидером, в том числе 19 лет в сфере финансовых услуг. Марк имеет шесть сертификатов AWS, включая сертификат ML Specialty Certification.