Исследовать

Представляем RGB-Stacking как новый эталон роботизированных манипуляций на основе зрения

Взять палку и балансировать ею на бревне или положить камешек на камень может показаться человеку простым — и вполне похожим — действием. Однако большинству роботов сложно справиться с несколькими такими задачами одновременно. Манипулирование палкой требует другого набора действий, чем укладка камней, не говоря уже о складывании различной посуды друг на друга или сборке мебели. Прежде чем мы сможем научить роботов выполнять такого рода задачи, им сначала необходимо научиться взаимодействовать с гораздо большим количеством объектов. Как часть Миссия DeepMind и в качестве шага к созданию более обобщаемых и полезных роботов мы изучаем, как дать роботам возможность лучше понимать взаимодействие объектов с различной геометрией.

В документе, который будет представлен на КОРЛ 2021 (Конференция по обучению роботов) и доступен в виде препринта на OpenReview, мы представляем RGB-Stacking как новый эталон роботизированных манипуляций на основе зрения. В этом тесте робот должен научиться захватывать различные объекты и балансировать их друг на друге. Что отличает наше исследование от предыдущих работ, так это разнообразие использованных объектов и большое количество эмпирических оценок, проведенных для подтверждения наших выводов. Наши результаты показывают, что сочетание моделирования и реальных данных можно использовать для изучения сложных манипуляций с несколькими объектами, и предлагают надежную основу для открытой проблемы обобщения на новые объекты. Чтобы поддержать других исследователей, мы открытый исходный код версию нашей моделируемой среды и выпустив дизайн для создания нашей среды реального робота с укладкой RGB, а также моделей RGB-объектов и информации для их 3D-печати. У нас также открытый исходный код коллекция библиотек и инструментов используется в наших исследованиях в области робототехники в более широком смысле.

Тест RGB-стекинга

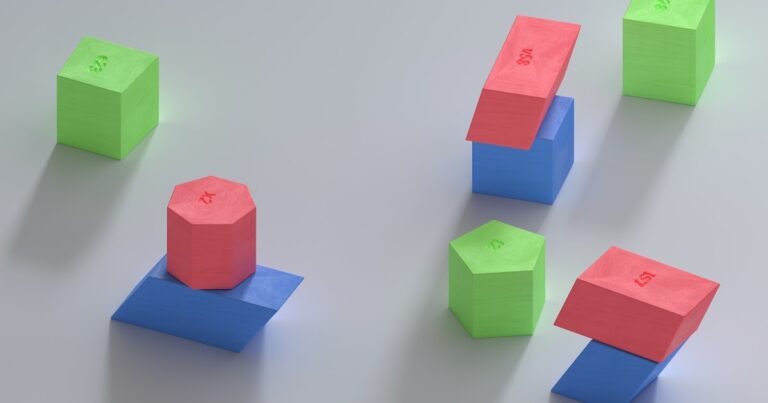

Наша цель с помощью RGB-Stacking — научить роботизированную руку с помощью обучения с подкреплением складывать объекты различной формы. Мы размещаем параллельный захват, прикрепленный к манипулятору робота, над корзиной и три объекта в корзине — красный, зеленый и синий (отсюда и название RGB). Задача проста: сложите красный предмет поверх синего в течение 20 секунд, а зеленый предмет будет служить препятствием и отвлечением внимания. Процесс обучения гарантирует, что агент приобретет обобщенные навыки посредством обучения на нескольких наборах объектов. Мы намеренно варьируем возможности захвата и укладки — качества, которые определяют, как агент может захватывать и укладывать каждый объект. Этот принцип проектирования заставляет агента демонстрировать поведение, выходящее за рамки простой стратегии выбора и размещения.

Каждый триплет ставит перед агентом свои уникальные задачи: Триплет 1 требует точного понимания верхнего объекта; Триплет 2 часто требует, чтобы верхний объект использовался в качестве инструмента для переворачивания нижнего объекта перед складыванием; Триплет 3 требует балансировки; Триплет 4 требует точного укладки (т. е. центроиды объектов должны быть выровнены); а верхний объект Triplet 5 может легко скатиться, если его не аккуратно сложить. Оценивая трудности этой задачи, мы обнаружили, что наш базовый сценарий, написанный вручную, имел показатель успеха при суммировании 51%.

Наш тест RGB-Stacking включает в себя две версии задач с разным уровнем сложности. В «Мастерстве навыков» наша цель — обучить одного агента, который умеет составлять заранее определенный набор из пяти троек. В «Обобщении навыков» мы используем те же тройки для оценки, но обучаем агента на большом наборе обучающих объектов — всего более миллиона возможных троек. Чтобы проверить генерализацию, эти обучающие объекты исключают семейство объектов, из которых были выбраны тестовые тройки. В обеих версиях мы разделяем процесс обучения на три этапа:

- Сначала мы обучаемся моделированию, используя готовый алгоритм RL: Максимальная апостериорная оптимизация политики (MPO). На этом этапе мы используем состояние симулятора, что позволяет провести быстрое обучение, поскольку положения объектов передаются непосредственно агенту, а не агенту, который должен научиться находить объекты на изображениях. Полученная в результате политика не может быть напрямую передана реальному роботу, поскольку эта информация недоступна в реальном мире.

- Затем мы обучаем новую политику моделирования, которая использует только реалистичные наблюдения: изображения и проприоцептивное состояние робота. Мы используем рандомизированное моделирование для улучшения передачи реальных изображений и динамики. Государственная политика служит учителем, предоставляя обучающемуся агенту корректировки его поведения, и эти корректировки воплощаются в новую политику.

- Наконец, мы собираем данные, используя эту политику, на реальных роботах и обучаем улучшенную политику на основе этих данных в автономном режиме, взвешивая хорошие переходы на основе изученной функции Q, как это сделано в Критическая регуляризованная регрессия (CRR). Это позволяет нам использовать данные, пассивно собранные в ходе проекта, вместо запуска трудоемкого алгоритма онлайн-обучения на реальных роботах.

Такое разделение нашего процесса обучения оказывается крайне важным по двум основным причинам. Во-первых, это позволяет нам вообще решить проблему, поскольку это заняло бы слишком много времени, если бы мы начинали с нуля непосредственно над роботами. Во-вторых, это увеличивает скорость наших исследований, поскольку разные люди в нашей команде могут работать над разными частями конвейера, прежде чем мы объединим эти изменения для общего улучшения.

Наш агент демонстрирует новые способы складывания 5 троек. Самый сильный результат с использованием Skill Mastery был у агента, основанного на зрении, который достиг среднего успеха в симуляции 79% (этап 2), успеха с нулевым выстрелом на реальных роботах 68% (этап 2) и 82% после одношагового улучшения политики от реальные данные (Этап 3). Тот же конвейер для обобщения навыков привел к тому, что последний агент достиг 54% успеха на реальных роботах (этап 3). Устранение этого разрыва между освоением навыков и обобщением остается открытой задачей.

В последние годы было проведено много работы по применению алгоритмов обучения для решения сложных масштабных задач манипулирования реальными роботами, но основное внимание в такой работе уделялось таким задачам, как захват, толкание или другие формы манипулирования отдельными объектами. Подход к RGB-стекингу, который мы описываем в нашей статье, сопровождается наши ресурсы по робототехнике теперь доступны на GitHub, приводит к удивительным стратегиям штабелирования и мастерству штабелирования подмножества этих объектов. Тем не менее, этот шаг лишь затрагивает поверхность того, что возможно – и проблема обобщения остается не полностью решенной. Поскольку исследователи продолжают работать над решением открытой проблемы истинного обобщения в робототехнике, мы надеемся, что этот новый эталон, а также среда, конструкции и инструменты, которые мы выпустили, внесут вклад в новые идеи и методы, которые могут сделать манипуляции еще проще, а роботов — более способными. .