Robotic Transformer 2 (RT-2) — это новая модель «видение-язык-действие» (VLA), которая учится как на веб-данных, так и на данных робототехники и переводит эти знания в обобщенные инструкции для управления роботами.

Высокопроизводительные модели визуального языка (VLM) обучаются на наборах данных веб-масштаба, что делает эти системы чрезвычайно эффективными в распознавании визуальных или языковых шаблонов и работе на разных языках. Но чтобы роботы достигли аналогичного уровня компетентности, им необходимо собирать данные о роботах из первых рук по каждому объекту, среде, задаче и ситуации.

В нашем бумагамы представляем Robotic Transformer 2 (RT-2), новую модель «видение-язык-действие» (VLA), которая учится как на веб-данных, так и на данных робототехники, и переводит эти знания в обобщенные инструкции для управления роботами, сохраняя при этом возможности веб-масштаба.

Эта работа основана на роботе-трансформере 1. (РТ-1), модель, обученная на многозадачных демонстрациях, которая может изучать комбинации задач и объектов, видимых в роботизированных данных. В частности, в нашей работе использовались демонстрационные данные робота RT-1, которые были собраны с помощью 13 роботов в течение 17 месяцев на офисной кухне.

RT-2 демонстрирует улучшенные возможности обобщения, а также семантическое и визуальное понимание помимо роботизированных данных, которым он подвергался. Это включает в себя интерпретацию новых команд и реагирование на команды пользователя путем выполнения элементарных рассуждений, таких как рассуждения о категориях объектов или высокоуровневых описаниях.

Мы также показываем, что включение цепочки мыслей позволяет RT-2 выполнять многоэтапные семантические рассуждения, например, решать, какой объект можно использовать в качестве импровизированного молотка (камень) или какой тип напитка лучше всего подойдет уставшему человеку. (энергетический напиток).

Адаптация VLM для роботизированного управления

RT-2 основан на VLM, которые принимают одно или несколько изображений в качестве входных данных и создают последовательность токенов, которые традиционно представляют текст на естественном языке. Такие VLM были успешно обучен на данных веб-масштаба для выполнения таких задач, как визуальный ответ на вопрос, создание подписей к изображениям или распознавание объектов. В своей работе мы адаптируем модель Pathways Language and Image (Пали-Х) и Воплощенная языковая модель Pathways (ПалМ-Э), которые будут служить основой RT-2.

Чтобы управлять роботом, его необходимо научить выводить действия. Мы решаем эту проблему, представляя действия в виде токенов в выходных данных модели (аналогично языковым токенам) и описывая действия как строки, которые могут обрабатываться стандартными методами. токенизаторы естественного языкапоказано здесь:

Строка начинается с флага, указывающего, следует ли продолжить или завершить текущий эпизод, без выполнения последующих команд, и следует за командами изменения положения и вращения рабочего органа, а также желаемого выдвижения захвата робота.

Мы используем ту же дискретизированную версию действий робота, что и в RT-1, и показываем, что преобразование ее в строковое представление позволяет обучать модели VLM на роботизированных данных, поскольку входные и выходные пространства таких моделей не должны быть разделены. измененный.

Обобщение и возникающие навыки

Мы провели серию качественных и количественных экспериментов на наших моделях RT-2 в ходе более чем 6000 роботизированных испытаний. Исследуя новые возможности RT-2, мы сначала искали задачи, которые потребуют объединения знаний из сетевых данных и опыта робота, а затем определили три категории навыков: понимание символов, рассуждение и распознавание человека.

Каждая задача требовала понимания визуально-семантических концепций и умения выполнять роботизированное управление для работы с этими концепциями. Такие команды, как «поднять сумку, которая вот-вот упадет со стола» или «переместить банан в сумму два плюс один» — когда роботу предлагается выполнить задачу манипулирования объектами или сценариями, никогда не встречавшимися в роботизированных данных — обязательны. знания, преобразованные из веб-данных в работу.

Во всех категориях мы наблюдали повышение производительности обобщения (улучшение более чем в 3 раза) по сравнению с предыдущими базовыми показателями, такими как предыдущие модели RT-1 и такие модели, как Visual Cortex (ВК-1), которые были предварительно обучены на больших наборах визуальных данных.

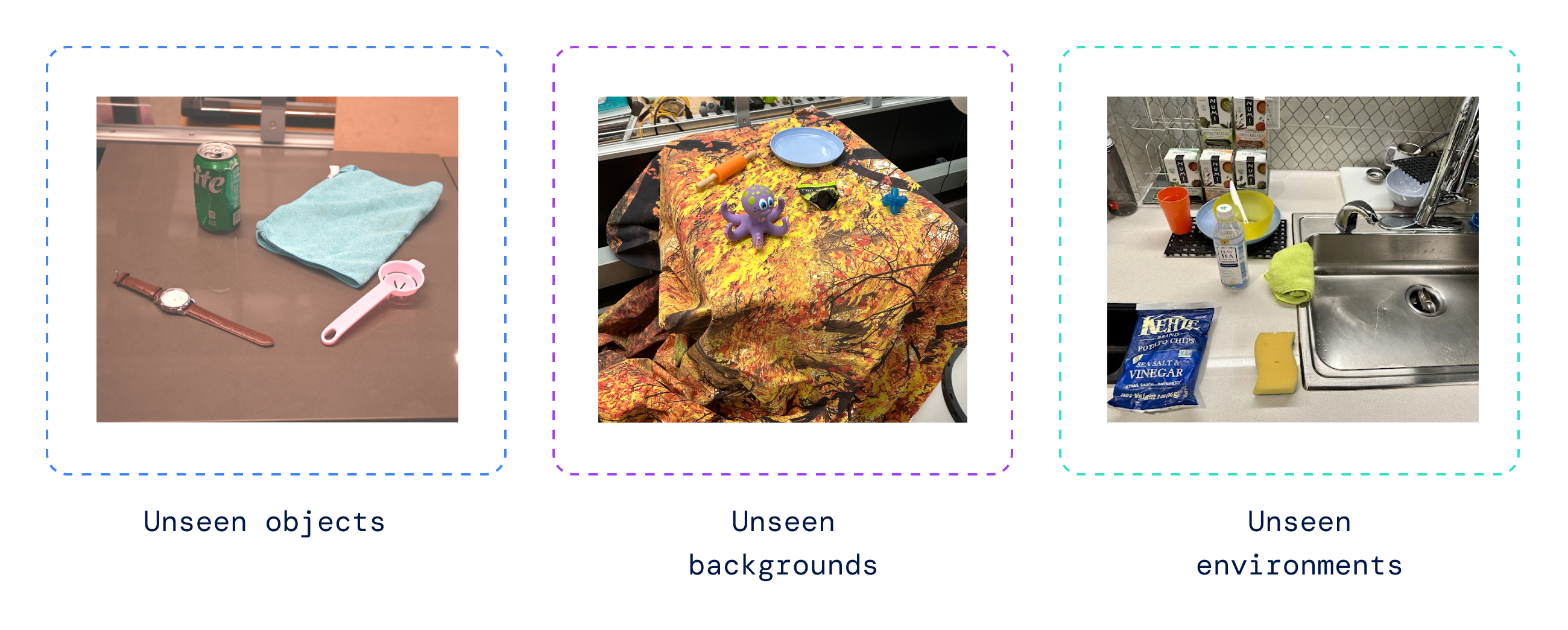

Мы также выполнили серию количественных оценок, начиная с первоначальных задач RT-1, для которых у нас есть примеры в данных робота, и продолжили с различной степенью ранее невидимых роботом объектов, фона и окружающей среды, которые требовали от робота изучите обобщение на предварительном обучении VLM.

RT-2 сохранил производительность при выполнении первоначальных задач, наблюдаемых в данных робота, и улучшил производительность в ранее неизвестных роботу сценариях с 32% до 62%, как у RT-1, что демонстрирует значительную выгоду от крупномасштабного предварительного обучения.

Кроме того, мы наблюдали значительные улучшения по сравнению с базовыми показателями, предварительно обученными на визуальных задачах, таких как VC-1 и многоразовые представления для роботизированных манипуляций (Р3М) и алгоритмы, использующие VLM для идентификации объектов, такие как Манипулирование объектами открытого мира (МОО).

Оценка нашей модели на открытом исходном коде Языковая таблица набора роботизированных задач, мы достигли 90% успеха в моделировании, что существенно улучшилось по сравнению с предыдущими базовыми показателями, включая БК-З (72%), РТ-1 (74%) и ЛАВА (77%).

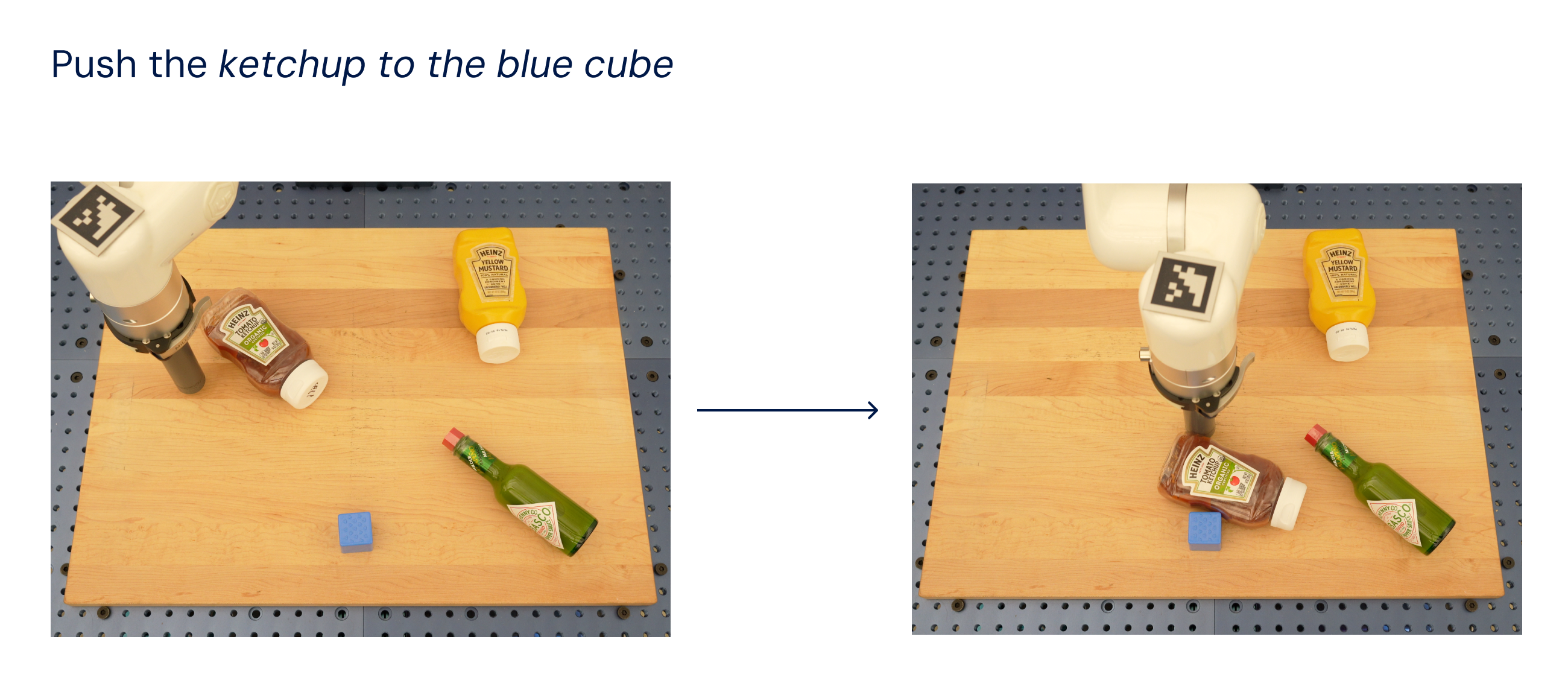

Затем мы оценили ту же модель в реальном мире (поскольку она была обучена на моделировании и реальных данных) и продемонстрировали ее способность обобщать новые объекты, как показано ниже, где ни один из объектов, кроме синего куба, не присутствовал в обучении. набор данных.

Вдохновлен методы подсказки цепочки мыслей, используемые в LLMмы исследовали наши модели, чтобы объединить роботизированное управление с цепочкой мыслей, чтобы можно было освоить долгосрочное планирование и навыки низкого уровня в рамках одной модели.

В частности, мы доработали вариант RT-2 всего на несколько сотен шагов градиента, чтобы повысить его способность совместно использовать язык и действия. Затем мы дополнили данные, включив в них дополнительный шаг «План», сначала описывающий цель действия, которое робот собирается предпринять, на естественном языке, затем следовали «Действие» и жетоны действий. Здесь мы показываем пример таких рассуждений и результирующее поведение робота:

С помощью этого процесса RT-2 может выполнять более сложные команды, требующие обдумывания промежуточных шагов, необходимых для выполнения инструкции пользователя. Благодаря своей магистрали VLM, RT-2 также может планировать как с помощью графических, так и текстовых команд, обеспечивая визуально обоснованное планирование, тогда как современные подходы «планируй и действуй», такие как SayCan не может видеть реальный мир и полностью полагаться на язык.

Развитие роботизированного управления

RT-2 показывает, что модели визуального языка (VLM) могут быть преобразованы в мощные модели визуального языка-действия (VLA), которые могут напрямую управлять роботом путем объединения предварительного обучения VLM с роботизированными данными.

Благодаря двум реализациям VLA на основе PaLM-E и PaLI-X, RT-2 приводит к значительному улучшению роботизированных политик и, что более важно, к значительному повышению производительности обобщения и новым возможностям, унаследованным от предварительной разработки языка видения в веб-масштабе. -обучение.

RT-2 — это не только простая и эффективная модификация существующих моделей VLM, но и перспективность создания физического робота общего назначения, который сможет рассуждать, решать проблемы и интерпретировать информацию для выполнения широкого спектра задач в реальных условиях. мир.