В быстро развивающемся мире искусственного интеллекта (ИИ) разработчики стремятся создавать машины, способные обучаться автономно. Область обучения с подкреплением, подмножество машинного обучения, играет решающую роль в этих усилиях, создавая основу для систем ИИ, чтобы учиться на своих действиях.

Недавняя разработка в RL становится популярной — обучение с подкреплением на основе отзывов людей. Этот подход сочетает в себе человеческое понимание с передовыми алгоритмами, обеспечивая эффективный и действенный способ обучения моделей ИИ.

В этой статье мы исследуем преимущества и проблемы RLHF и представляем 5 ведущих компаний на рынке, которые предлагают услуги RLHF.

Сравнение 5 лучших компаний, предлагающих услуги RLHF

Если вы хорошо знакомы с RLHF и хотите выбрать поставщика услуг, вот таблица, в которой сравниваются лучшие поставщики услуг на рынке.

Таблица 1. Сравнение поставщиков услуг RLHF по категории присутствия на рынке

| Компания | Размер толпы | Доля клиентов среди топ-5 покупателей | Отзывы клиентов |

|---|---|---|---|

| кликворкер | 4,5 млн+ | 80% | – Г2: 3,9 – Доверительный пилот: 4.4 – Каптерра: 4,4 |

| Appen | 1 млн+ | 60% | – Г2: 4,3 – Каптерра: 4.1 |

| плодовитый | 130 тыс.+ | 40% | – Г2: 4,3 – Доверительный пилот: 2.7 |

| Всплеск ИИ | Н/Д | 60% | Н/Д |

| Толока А.И. | 245к+ | 20% | – Доверительный пилот: 2.8 – Каптерра: 4.0 |

Таблица 2: Сравнение поставщиков услуг RLHF по категории набора функций

| Компания | Мобильное приложение | Доступность API | Сертификация ISO 27001 | Нормы поведения | Соответствие GDPR |

|---|---|---|---|---|---|

| кликворкер | истинный | истинный | истинный | истинный | истинный |

| Appen | истинный | истинный | истинный | истинный | истинный |

| плодовитый | ЛОЖЬ | истинный | ЛОЖЬ | истинный | истинный |

| Всплеск ИИ | ЛОЖЬ | истинный | истинный | ЛОЖЬ | ЛОЖЬ |

| Толока А.И. | истинный | истинный | истинный | истинный | истинный |

Примечания и наблюдения из таблиц:

- Все данные, добавленные в таблицы, основаны на заявлениях компании.

- Компании, выбранные для этого сравнения, были основаны на актуальности их услуг.

- Все поставщики услуг предлагают возможности интеграции API.

Как мы выбирали критерии выбора лучшего поставщика услуг RLHD

В этом разделе освещаются критерии, которые мы использовали для выбора 5 лучших поставщиков услуг, сравниваемых в этой статье. Читатели также могут использовать этот критерий, чтобы найти то, что подходит для их бизнеса.

Присутствие на рынке

Доля клиентов среди топ-5 покупателей

Доля рынка компании имеет решающее значение для ее возможностей. Мы можем оценить его присутствие на рынке определяя свои ссылки среди 5 ведущих технологических компаний, которые являются крупнейшими покупателями их услуг. Эта оценка, вероятно, коррелирует с процентной долей 5 ведущих технологических компаний, обслуживаемых провайдером RLHF. В состав компаний входят:

- Samsung

- Яблоко

- Майкрософт

- Мета

Отзывы Пользователей

Анализ отзывов пользователей на таких платформах, как G2 и Trustpilot, может помочь понять общую эффективность компании. Однако важно убедиться, что отзывы относятся к рассматриваемой услуге, поскольку компании предлагают широкий спектр продуктов и услуг.

Набор функций

Возможности платформы

Также важно проверить, какие возможности предлагает поставщик услуг. Предлагают ли они мобильное приложение или API-интеграция способность?

Методы защиты данных

В связи с растущими угрозами кибербезопасности важно иметь эффективные методы защиты данных. Мы искали ИСО 27001 сертификация и соответствие GDPR.

Честная торговля

Неэтичные действия вашего делового партнера повлияют на вашу репутацию. Поэтому убедитесь, что поставщик услуг следует четкому нормы поведения добросовестного отношения к работникам.

Ограничения и следующие шаги

- критерии выбора компании будет уточняться по мере развития рынка и нашего понимания рынка.

- заявления о возможностях компании не были проверены. Предполагается, что поставщик услуг предлагает возможность, если эта возможность выделена на странице его услуг или в тематических исследованиях по состоянию на ноябрь 2022 г. Мы можем проверить заявления компаний в будущем.

- Возможности компании количественно не измерялись. Мы проверили, были ли предложены возможности или нет. В сравнительном анализе продуктов могут быть введены количественные показатели.

Что такое обучение с подкреплением на основе обратной связи с человеком (RLHF)?

Обучение с подкреплением на основе отзывов людей, или RLHF, — это метод, при котором ИИ учится оптимальным действиям на основе отзывов, предоставленных человеком. Чтобы лучше понять концепцию RLHF, важно понять обучение с подкреплением (RL).

Что такое обучение с подкреплением?

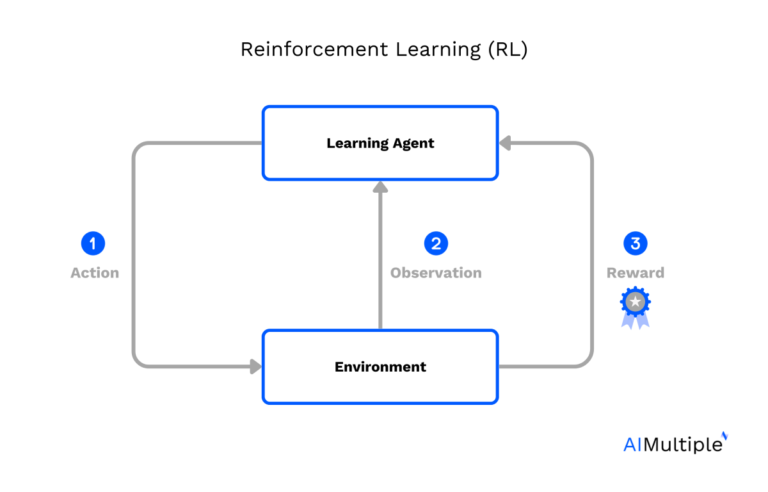

RL — это тип машинного обучения, в котором агент (алгоритм RL) учится принимать решения, совершая действия в среда (все, с чем взаимодействует агент) для достижения цели. Агент получает вознаграждение или наказание в зависимости от предпринятых действий, со временем учась максимизировать вознаграждение.

Обучение с подкреплением на основе отзывов людей

RLHF, с другой стороны, совершенствует этот процесс, интегрируя обратную связь с человеком в цикл обучения. Вместо того, чтобы полагаться исключительно на функцию вознаграждения, заданную программистом, RLHF использует человеческий интеллект для управления процессом обучения.

Проще говоря, агент учится не только на последствиях своих действий, но и на обратной связи с людьми. Эта человеческая обратная связь может быть корректирующей, указывая, где агент ошибся, или утвердительной, подкрепляя правильные решения, принятые агентом.

Аналогия с приготовлением кофе для упрощения концепции RLHF

Представьте, что вы учите робота готовить чашку кофе. Используя традиционное RL, робот будет экспериментировать и выяснять процесс методом проб и ошибок, что потенциально может привести ко многим неоптимальным чашкам или даже к некоторым бедствиям. Однако с RLHF человек может обеспечить обратную связь, уводя робота от ошибок и направляя его к правильной последовательности действий, сокращая время и потери, связанные с процессом обучения. Чтобы визуализировать концепцию, см. изображение ниже.

Преимущества РЛХФ

1. Повышение эффективности обучения

Одним из основных преимуществ RLHF является его потенциал для повышения эффективности обучения. Включая обратную связь с человеком, алгоритмы RL могут обойти необходимость исчерпывающих процессов проб и ошибок, ускоряя кривую обучения и быстрее достигая оптимальных результатов.

2. Устранение двусмысленности и сложности

RLHF также может более эффективно справляться с неоднозначными или сложными ситуациями. В обычном RL определение эффективной функции вознаграждения для сложных задач может быть довольно сложной задачей. RLHF, с его способностью учитывать нюансы обратной связи с человеком, может более компетентно ориентироваться в таких ситуациях.

3. Безопасное и этичное обучение

Наконец, RLHF предоставляет возможности для более безопасной и этичной разработки ИИ. Человеческая обратная связь может помочь предотвратить обучение ИИ вредному или нежелательному поведению. Включение человека в цикл может помочь обеспечить этичную и безопасную работу систем ИИ, что имеет первостепенное значение в современном мире.

Проблемы и рекомендации для RLHF

Несмотря на то, что RLHF сулит огромные перспективы, у него также есть свои проблемы. Однако с каждой проблемой приходит возможность для инноваций и роста.

1. Качество и постоянство обратной связи с людьми

Эффективность RLHF в значительной степени зависит от качества и согласованности обратной связи с человеком. Непоследовательная или ошибочная обратная связь может сорвать процесс обучения.

Рекомендация

Эта проблема может быть смягчена путем включения нескольких источников обратной связи или использования сложных систем оценки обратной связи, которые оценивают надежность поставщиков обратной связи.

2. Масштабируемость

Поскольку системы ИИ решают все более сложные задачи, объем обратной связи, необходимой для эффективного обучения, может расти в геометрической прогрессии, что затрудняет масштабирование.

Рекомендация

Одним из способов решения этой проблемы является объединение RLHF с традиционным RL. На начальных этапах обучения может использоваться человеческая обратная связь, в то время как более продвинутые этапы полагаются на предварительно полученные знания и исследования, что снижает потребность в постоянном человеческом участии.

3. Чрезмерная зависимость от обратной связи с людьми

Существует риск того, что система искусственного интеллекта может стать чрезмерно зависимой от обратной связи с человеком, что ограничит ее способность к самостоятельному исследованию и обучению.

Рекомендация

Потенциальное решение состоит в том, чтобы реализовать убывающую зависимость от обратной связи с человеком. По мере того, как система ИИ совершенствуется и становится более компетентной, зависимость от обратной связи с человеком должна постепенно уменьшаться, позволяя системе учиться самостоятельно.

4. Рабочая сила и затраты

Существуют затраты, связанные с RLHF. Такой как:

- Привлечение экспертов для предоставления обратной связи

- Технология и инфраструктура, необходимые для реализации RLHF

- Разработка удобных интерфейсов для предоставления обратной связи

- Обслуживание и обновление этих систем

Рекомендации

Работа с поставщиком услуг RLHF может помочь упростить процесс использования RLHF для обучения моделей ИИ.

дальнейшее чтение

Если вам нужна помощь в поиске поставщика или у вас есть какие-либо вопросы, не стесняйтесь обращаться к нам:

Найдите подходящих поставщиков

Поделись LinkedIn