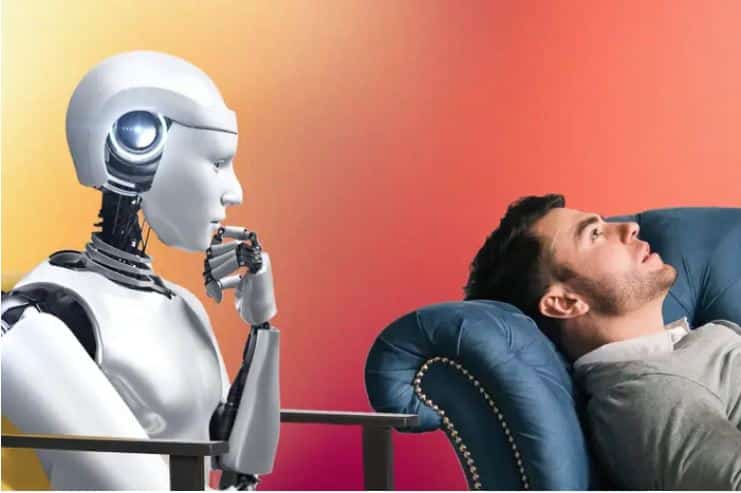

Может ли ваш компьютер стать вашим психотерапевтом? По мере роста популярности ChatGPT среди цифровых аборигенов онлайн-потребители постоянно находят новые способы использования генеративного ИИ в своей повседневной жизни.

От простых ответов на математические вопросы до составления списков продуктов ChatGPT стал чем-то вроде феномена в современном домашнем хозяйстве. Вопрос в том, сможет ли он теперь заменить вашего психотерапевта?

Социальные сети в настоящее время сходят с ума по Консультант ChatGPT, и начали задавать чат-боту ИИ медицинские вопросы и даже спрашивать у него жизненный совет. Один TikToker даже сообщил, что они заменили своего терапевта на ChatGPT, чтобы сэкономить деньги, но при этом получать достаточную поддержку.

Однако может ли использование ChatGPT стать проблемой для медицинских работников?

«Будьте настроены скептически. Чат-боты с искусственным интеллектом не предназначены для использования в качестве замены терапии, психотерапии или любого вида психиатрического вмешательства», — заявляет Брюс Арноу, профессор кафедры психиатрии Стэнфордского университета. «Они просто еще недостаточно продвинулись для этого, и мы не знаем, будут ли они когда-либо».

Оставайтесь с нами, когда мы окунемся в технологическое будущее терапии и обсудим, сможет ли ChatGPT когда-либо действительно заменить профессиональные методы лечения психических заболеваний.

Может ли ChatGPT быть вашим терапевтом?

Так как же будет выглядеть сеанс терапии с чат-ботом с искусственным интеллектом в 2023 году? Для большинства пользователей они, кажется, просто сообщают своему чат-боту о проблемах, которые они традиционно сообщали терапевту, в надежде, что генеративный ИИ ответит полезным советом.

Одним из самых привлекательных качеств терапевта с искусственным интеллектом является способность способность разговаривать с машиной а не другого человека. Для пользователей, которые изо всех сил пытаются открыться и поделиться своими чувствами в реальном мире, ChatGPT может стать легкой отдушиной и безопасным пространством для уязвимости.

Вопрос в том, как ChatGPT отвечает на более важные вопросы, такие как суицидальные мысли? Доктор Оливия Увамахоро Уильямс, сопредседатель Американской ассоциации консультирования, проверила именно это в исследовании, в котором она представила различным генеративным ИИ-ботам серию трудных разговоров.

«Все они будут давать очень разумные ответы», — заключила она. «Включая ресурсы, национальные ресурсы — так что это было приятно видеть. Я подумал: «Хорошо, эти вещи очень точны. Сгенерированный ответ очень похож на консультанта, что-то вроде терапевта».

Вопрос в том, могут ли эти ответы открыть новое будущее для терапии с использованием ИИ?

Разблокировка терапевтических приложений на основе искусственного интеллекта

ИИ продолжает преобразовывать мир вокруг нас. Из очков с искусственным интеллектом, которые вы можете заказать онлайн для работы на базе ИИ в корпоративном секторе после коронавируса возможности этой умной технологии безграничны.

Поэтому неудивительно, что ИИ удалось проникнуть и в сектор здравоохранения в 2023 году. Фактически, некоторые специалисты в области психического здоровья считают, что они могут улучшить будущее терапии в форме приложения для консультирования.

Терапевтическое приложение на базе искусственного интеллекта Wysa — лишь один из примеров этого. Будучи платформой, созданной профессиональными психиатрами, приложение общается с пациентами с помощью ИИ, но имеет полнофункциональный сценарий для чтения, созданный на основе мнений экспертов и управляемых ответов.

«Очевидно, что существует много литературы о том, как ИИ-чат процветает с запуском ChatGPT и так далее, но я думаю, важно подчеркнуть, что Wysa очень специфична для предметной области и очень тщательно построена с учетом клинических ограничений безопасности», утверждает Рамакант Вемпати, основатель платформы.

«И мы не используем генеративный текст, мы не используем генеративные модели. Это сконструированный диалог, поэтому сценарий предварительно написан и проверен с помощью критического набора данных о безопасности, который мы проверили на реакцию пользователей». он продолжил.

Хотя эти приложения на основе искусственного интеллекта не могут заменить традиционную терапию, основатели Wysa считают, что они дают пациентам больше возможностей для конверсии по мере необходимости, вместо того, чтобы ждать традиционного приема в один слот.

Есть ли опасения у практикующих?

По мере того, как мы вступаем в будущее терапии «на ходу», у клиницистов все еще есть опасения? Хотя было доказано, что чат-боты генерируют, казалось бы, адекватные ответы на многие проблемы психического здоровья, некоторые эксперты считают, что традиционные формы терапии по-прежнему являются более безопасной альтернативой.

«В этом процессе нет человека. Поэтому первое, что меня беспокоит, — это ответственность», — говорит доктор Оливия Увамахоро Уильямс. «Отсутствует безопасность, о которой мы должны быть открытыми и честными, потому что, если что-то случится, кто будет нести ответственность?»

Традиционные формы терапии также позволяют пациенту и терапевту сформировать эмоциональную связь, которую не может воспроизвести генеративный ИИ. Эксперты считают, что с большим количеством доверия, связанного с уязвимостью, человеку всегда будет легче общаться и индивидуализироваться в качестве альтернативы компьютеризированной.

«Я думаю, что в будущем он, вероятно, превзойдет нас — даже терапевтов — во многих измеримых аспектах. Но одна вещь, которую он не может сделать, — это быть человеком», — утверждает доктор Рассел Фулмер, директор по консультированию в Университете Хассона. «Терапевтические отношения — действительно важный фактор. Это объясняет многие положительные изменения, которые мы наблюдаем».

Вопрос в том, можно ли использовать терапию с искусственным интеллектом, чтобы просто улучшить разговор? Время покажет.

Подписывайтесь на нашу новостную рассылку

Будьте в курсе последних новостей о больших данных.