По мере развития ИИ доступ исследовательского сообщества к генеративным инструментам на базе ИИ, таким как языковые модели, становится важным для создания инноваций. Однако сегодняшние модели ИИ часто находятся за закрытыми стенами, что препятствует инновациям. Выпуск LLaMA 2 компанией Meta призван демократизировать это пространство, позволяя исследователям и коммерческим пользователям во всем мире исследовать и расширять границы того, чего может достичь ИИ.

В этой статье мы объясняем модель Meta LLaMa и ее последнюю версию LLaMa 2.

Что такое ЛЛаМа?

В феврале 2023 года Meta анонсировала LLaMA, что означает метаискусственный интеллект большой языковой модели. Эта большая языковая модель (LLM) была обучена на моделях различных размеров, включающих от 7 до 65 миллиардов параметров. Модели LLaMa изменяются из-за размеров параметров1:

- Параметры 7B (обучено на 1 трлн токенов)

- 13В параметры

- 33B параметров (обучено на 1,4 трлн токенов)

- 65B параметров (обучено на 1,4 трлн токенов)

Meta AI утверждает, что LLaMa — это уменьшенная языковая модель, которая может быть более подходящей для переобучения и тонкой настройки. Это преимущество, поскольку точно настроенные модели больше подходят для коммерческих организаций и конкретных видов использования.

Для тонкой настройки LLM для корпоративных целей ознакомьтесь с нашим руководством.

В отличие от многих мощных крупноязыковых моделей, которые обычно доступны только через ограниченные API, Meta AI решил сделать веса моделей LLaMA доступными для исследовательского сообщества ИИ под некоммерческой лицензией. Первоначально доступ предоставлялся выборочно академическим исследователям, лицам, связанным с государственными учреждениями, организациями гражданского общества и академическими учреждениями по всему миру.

Как проходил обучение LLaMa?

Подобно другим большим языковым моделям, LLaMA работает, получая строку слов в качестве входных данных и предвосхищая следующее слово для итеративного создания текста.

При обучении этой языковой модели предпочтение отдавалось тексту из 20 основных языков с наибольшим количеством носителей, особенно тех, которые используют латиницу и кириллицу.

Тренировочные данные LLaMa в основном взяты с крупных общедоступных веб-сайтов и форумов, таких как2:

- Веб-страницы, извлеченные CommonCrawl

- Репозитории исходного кода с открытым исходным кодом из GitHub

- Википедия на 20 разных языках

- Книги общественного достояния из Project Gutenberg

- Исходный код LaTeX для научных статей, загруженных в ArXiv

- Вопросы и ответы с веб-сайтов Stack Exchange

Как LLaMa работает по сравнению с другими большими языковыми моделями?

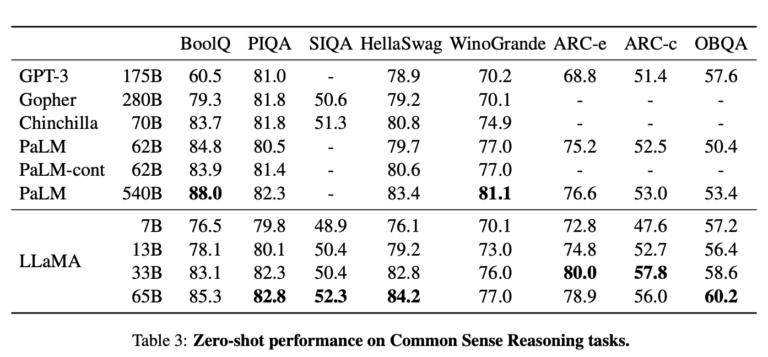

По словам создателей LLaMA, модель с 13 миллиардами параметров превосходит GPT-3 (со 175 миллиардами параметров) в большинстве тестов обработки естественного языка (NLP).3 Кроме того, их самая большая модель эффективно конкурирует с моделями высшего уровня, такими как PaLM и Chinchilla.

Правдивость и предвзятость

- LLaMa работает лучше, чем GPT-3, в тесте на достоверность, используемом при измерении производительности обоих LLM. Однако, как показывают результаты, LLM все еще нуждаются в улучшении с точки зрения достоверности.

- LLaMa с параметрами 65B выдает менее предвзятые подсказки по сравнению с другими крупными LLM, такими как GPT3.

Что такое ЛЛаМа 2?

18 июля 2023 года Meta и Microsoft совместно объявили о своей поддержке семейства больших языковых моделей LLaMa 2 на платформах Azure и Windows.4 И Meta, и Microsoft едины в своей приверженности демократизации ИИ и обеспечению широкой доступности моделей ИИ, и Meta занимает открытую позицию с LlaMa 2. Впервые модель открыта для исследований и коммерческого использования.

Дизайн LLaMa 2 призван помочь разработчикам и организациям в создании генеративных инструментов и опыта ИИ. Они дают разработчикам свободу выбора типов моделей, которые они хотят разрабатывать, поддерживая как открытые, так и пограничные модели.

Кто может использовать LLaMa 2?

- Клиенты платформы Microsoft Azure могут точно настроить и использовать модели LLaMa 2 с параметрами 7B, 13B и 70B.

- Кроме того, он доступен через Amazon Web Services, Hugging Face и других поставщиков.5

- LLaMa будет разработан для эффективной работы в локальной среде Windows. Разработчики, работающие с Windows, могут использовать LlaMa, направив его поставщику исполнения DirectML через среду выполнения ONNX.

Если у вас есть вопросы или вам нужна помощь в поиске поставщиков, не стесняйтесь обращаться к нам:

Найдите подходящих поставщиков

- «Представляем LLaMA: базовую языковую модель с 65 миллиардами параметров». Мета ИИ, 24 февраля 2023 г., https://ai.facebook.com/blog/large-language-model-llama-meta-ai/. По состоянию на 24 июля 2023 г.

- «ЛаМА». Википедия, https://en.wikipedia.org/wiki/LLaMA. По состоянию на 24 июля 2023 г.

- «LLaMA: открытые и эффективные модели базовых языков». arXiv, 13 июня 2023 г., https://arxiv.org/pdf/2302.13971.pdf. По состоянию на 24 июля 2023 г.

- «Microsoft и Meta расширяют свое партнерство в области ИИ с LLama 2 на Azure и Windows — официальный блог Microsoft». Официальный блог Майкрософт, 18 июля 2023 г., https://blogs.microsoft.com/blog/2023/07/18/microsoft-and-meta-expand-their-ai-partnership-with-llama-2-on-azure-and-windows/. По состоянию на 24 июля 2023 г.

- «Мета и Microsoft представляют новое поколение Llama». Мета ИИ, 18 июля 2023 г., https://ai.meta.com/blog/llama-2/. По состоянию на 24 июля 2023 г.

Поделись LinkedIn