Во время чисто любопытного исследования рука JACO обнаруживает, как собирать кубики, перемещать их по рабочему пространству и даже проверяет, можно ли их балансировать на краях.

Любопытное исследование позволяет OP3 ходить прямо, балансировать на одной ноге, садиться и даже безопасно ловить себя, когда прыгает назад — и все это без конкретной целевой задачи для оптимизации.

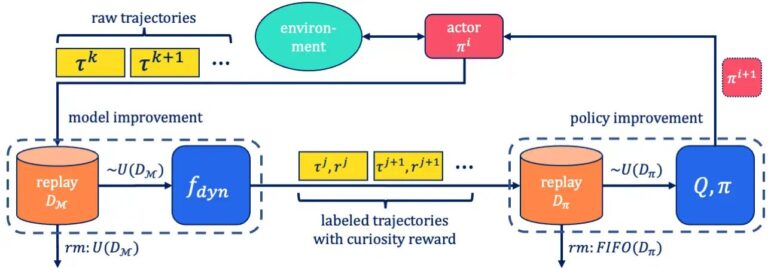

Внутренняя мотивация (1, 2) может быть мощной концепцией, позволяющей наделить агента механизмом непрерывного исследования окружающей среды при отсутствии информации о задаче. Одним из распространенных способов реализации внутренней мотивации является изучение любопытства (3, 4). С помощью этого метода модель прогнозирования реакции среды на действия агента обучается вместе с политикой агента. Эту модель можно также назвать моделью мира. Когда действие предпринимается, модель мира делает прогноз относительно следующего наблюдения агента. Затем этот прогноз сравнивается с истинным наблюдением, сделанным агентом. Важно отметить, что вознаграждение, данное агенту за выполнение этого действия, зависит от ошибки, которую он допустил при прогнозировании следующего наблюдения. Таким образом, агент вознаграждается за действия, результаты которых еще недостаточно предсказуемы. Одновременно обновляется модель мира, чтобы лучше предсказать результат указанного действия.

Этот механизм успешно применялся в настройках политики, например, для прохождения двухмерных компьютерных игр без присмотра (4) или для обучения общей политике, которая легко адаптируется к конкретным последующим задачам (5). Тем не менее, мы считаем, что истинная сила любопытного обучения заключается в разнообразном поведении, возникающем в процессе любопытного исследования: по мере того, как меняется цель любопытства, меняется и результирующее поведение агента, благодаря чему обнаруживается множество сложных политик, которые можно было бы использовать позже. если они были сохранены и не перезаписаны.

В этой статьемы делаем два вклада в изучение обучения на основе любопытства и используем его эмерджентное поведение: во-первых, мы вводим СелМо, внеполитическая реализация самомотивированного, основанного на любопытстве метода исследования. Мы показываем, что с помощью SelMo осмысленное и разнообразное поведение возникает исключительно на основе оптимизации цели любопытства в моделируемых областях манипуляции и передвижения. Во-вторых, мы предлагаем сосредоточить внимание в применении обучения любопытству на выявление и сохранение возникающих промежуточных форм поведения. Мы подтверждаем эту гипотезу экспериментом, который перезагружает обнаруженное поведение в качестве предварительно обученных вспомогательных навыков в иерархической установке обучения с подкреплением.

Мы запускаем SelMo в двух смоделированных роботизированных доменах с непрерывным управлением: на руке JACO с 6 степенями свободы с трехпалым захватом и на роботе-гуманоиде с 20 степенями свободы, OP3. Соответствующие платформы представляют собой сложную среду обучения для манипулирования объектами и передвижения соответственно. Оптимизируя только для любопытства, мы наблюдаем, что сложное интерпретируемое человеком поведение возникает в ходе тренировочных прогонов. Например, JACO учится поднимать и перемещать кубики без присмотра, а OP3 учится балансировать на одной ноге или безопасно садиться, не падая.

.jpg)

.jpg)

Однако впечатляющее поведение, наблюдаемое во время любопытного исследования, имеет один существенный недостаток: оно непостоянно, поскольку постоянно меняется в зависимости от функции вознаграждения за любопытство. Поскольку агент продолжает повторять определенное поведение, например, JACO поднимает красный куб, вознаграждение за любопытство, накопленное этой политикой, уменьшается. Следовательно, это приводит к изучению измененной политики, которая снова получает более высокую награду за любопытство, например, перемещение куба за пределы рабочего пространства или даже внимание к другому кубу. Но это новое поведение перезаписывает старое. Однако мы считаем, что сохранение поведения, возникающего в результате любопытного исследования, дает агенту ценный набор навыков для более быстрого изучения новых задач. Чтобы проверить эту гипотезу, мы поставили эксперимент, чтобы проверить полезность самооткрытых навыков.

.jpg)

Мы относимся к случайно выбранным снимкам из разных фаз любопытного исследования как к вспомогательным навыкам в модульной структуре обучения (7) и измеряем, насколько быстро можно освоить новый целевой навык, используя эти вспомогательные средства. В случае с группой JACO мы поставили перед собой целевую задачу «поднять красный куб» и использовали пять случайно выбранных поведенческих моделей, обнаруженных нами самими, в качестве вспомогательных. Мы сравниваем изучение этой последующей задачи с базовым уровнем SAC-X (8), в котором используется учебная программа функций вознаграждения для поощрения достижения и перемещения красного куба, что в конечном итоге также облегчает обучение поднятию тяжестей. Мы обнаружили, что даже эта простая установка для повторного использования навыков уже ускоряет процесс обучения последующему заданию соизмеримо с разработанной вручную учебной программой вознаграждения. Результаты показывают, что автоматическая идентификация и сохранение полезного поведения, возникающего в результате любопытного исследования, является плодотворным направлением будущих исследований в области обучения с подкреплением без учителя.