Онлайн-игры и социальные сообщества предлагают своим пользователям функции голосового и текстового чата для общения. Хотя голосовой и текстовый чат часто способствуют дружескому подшучиванию, он также может привести к таким проблемам, как разжигание ненависти, киберзапугивание, преследование и мошенничество. Сегодня многие компании полагаются исключительно на модераторов при проверке токсичного контента. Однако проверка нарушений в чате отнимает много времени, подвержена ошибкам и ее сложно масштабировать.

В этом посте мы представляем решения, которые позволяют модерировать аудио- и текстовые чаты с помощью различных сервисов AWS, включая Amazon Transcribe, Amazon Comprehend, Amazon Bedrock и Amazon OpenSearch Service.

Социальным платформам требуется готовое решение для модерации, которое легко запустить, но они также требуют настройки для управления различными политиками. Задержка и стоимость также являются критическими факторами, которые необходимо принимать во внимание. Организуя классификацию токсичности с помощью больших языковых моделей (LLM) с использованием генеративного искусственного интеллекта, мы предлагаем решение, которое сочетает в себе простоту, задержку, стоимость и гибкость для удовлетворения различных требований.

Пример кода для этого поста доступен в Репозиторий GitHub.

Рабочий процесс модерации аудиочата

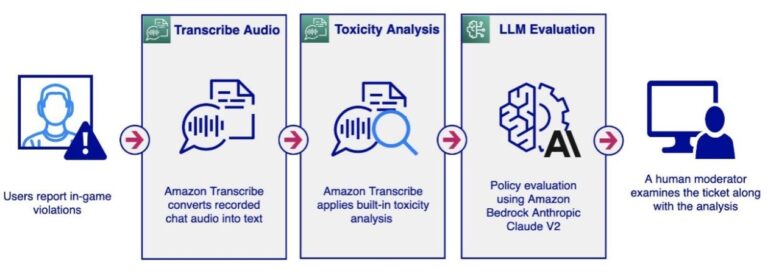

Рабочий процесс модерации аудиочата может быть инициирован пользователем, сообщающим другим пользователям игровой платформы о нарушениях политики, таких как ненормативная лексика, разжигание ненависти или преследования. Это представляет собой пассивный подход к модерации аудио. Система записывает все аудиоразговоры без немедленного анализа. При получении отчета рабочий процесс извлекает связанные аудиофайлы и инициирует процесс анализа. Затем модератор-человек просматривает сообщаемый разговор, исследуя его содержание, чтобы определить, нарушает ли он политику платформы.

Альтернативно, рабочий процесс может быть запущен заранее. Например, в социальном аудиочате система может записывать все разговоры и проводить анализ.

Как пассивный, так и упреждающий подходы могут запустить следующий конвейер аудиоанализа.

Рабочий процесс модерации аудио включает в себя следующие шаги:

- Рабочий процесс начинается с получения аудиофайла и его сохранения в корзине Amazon Simple Storage Service (Amazon S3) для доступа к Amazon Transcribe.

- Амазонка Транскрипт

StartTranscriptionJobAPI вызывается с включенным обнаружением токсичности. Amazon Transcribe преобразует аудио в текст, предоставляя дополнительную информацию об анализе токсичности. Дополнительную информацию об анализе токсичности см. в разделе Помечать недопустимые выражения в устных разговорах с помощью Amazon Transcribe Toxicity Detection. - Если анализ токсичности возвращает показатель токсичности, превышающий определенный порог (например, 50%), мы можем использовать базы знаний для Amazon Bedrock, чтобы оценить сообщение на соответствие настроенным политикам с использованием LLM.

- Модератор-человек получает подробный отчет о модерации аудио, в котором выделяются сегменты разговора, которые считаются токсичными и нарушают политику, что позволяет ему принять обоснованное решение.

На следующем снимке экрана показан пример приложения, отображающего анализ токсичности для аудиосегмента. Он включает в себя исходную транскрипцию, результаты анализа токсичности Amazon Transcribe и анализ, проведенный с использованием базы знаний Amazon Bedrock с помощью модели Amazon Bedrock Anthropic Claude V2.

Анализ LLM предоставляет результат нарушения (Да или Нет) и объясняет причину решения модели относительно нарушения политики. Кроме того, база знаний включает в себя справочные документы по политике, использованные при оценке, предоставляя модераторам дополнительный контекст.

Amazon Transcribe Обнаружение токсичности

Amazon Transcribe — это сервис автоматического распознавания речи (ASR), который позволяет разработчикам легко добавлять в свои приложения возможности преобразования речи в текст. Рабочий процесс модерации аудио использует Amazon Transcribe Toxicity Detection, который представляет собой функцию машинного обучения (ML), которая использует аудио и текстовые сигналы для идентификации и классификации голосового токсичного контента по семи категориям, включая сексуальные домогательства, разжигание ненависти и угрозы. , оскорбления, ненормативная лексика, оскорбления и графическая лексика. Помимо анализа текста, функция обнаружения токсичности использует речевые сигналы, такие как тон и высота звука, для выявления токсических намерений в речи.

Рабочий процесс модерации аудио активирует оценку политики LLM только тогда, когда анализ токсичности превышает установленный порог. Такой подход уменьшает задержку и оптимизирует затраты за счет выборочного применения LLM, отфильтровывая значительную часть трафика.

Используйте оперативное проектирование LLM для адаптации к индивидуальным политикам

Предварительно обученные модели обнаружения токсичности от Amazon Transcribe и Amazon Comprehend предоставляют широкую таксономию токсичности, которая обычно используется социальными платформами для модерации пользовательского контента в аудио и текстовых форматах. Хотя эти предварительно обученные модели эффективно обнаруживают проблемы с низкой задержкой, вам может понадобиться решение для обнаружения нарушений политик вашей конкретной компании или бизнес-домена, чего невозможно достичь только с помощью предварительно обученных моделей.

Кроме того, выявление нарушений в контекстных разговорах, таких как выявление сексуальный уход за ребенком разговоры, требует настраиваемого решения, которое включает в себя рассмотрение сообщений чата и контекста за его пределами, такого как возраст пользователя, пол и история разговоров. Именно здесь LLM могут предложить гибкость, необходимую для расширения этих требований.

Amazon Bedrock — это полностью управляемый сервис, предлагающий на выбор высокопроизводительные базовые модели (FM) от ведущих компаний, занимающихся искусственным интеллектом. Эти решения используют Anthropic Claude v2 от Amazon Bedrock для модерации аудиотранскрипций и текстовых сообщений чата с использованием гибкого шаблона приглашения, как показано в следующем коде:

Шаблон содержит заполнители для описания политики, сообщения чата и дополнительных правил, требующих модерации. Модель Anthropic Claude V2 предоставляет ответы в указанном формате (Да или Нет), а также анализ, объясняющий, почему, по ее мнению, сообщение нарушает политику. Такой подход позволяет вам определять гибкие категории модерации и формулировать свою политику на человеческом языке.

Традиционный метод обучения собственной модели классификации включает в себя громоздкие процессы, такие как аннотирование данных, обучение, тестирование и развертывание модели, требующие опыта специалистов по данным и инженеров ML. LLM, напротив, предлагают высокую степень гибкости. Бизнес-пользователи могут изменять подсказки на человеческом языке, что приводит к повышению эффективности и сокращению циклов итераций при обучении модели машинного обучения.

Базы знаний Amazon Bedrock

Хотя разработка подсказок эффективна для настройки политик, внедрение длинных политик и правил непосредственно в подсказки LLM для каждого сообщения может привести к задержке и увеличению затрат. Для решения этой проблемы мы используем базы знаний Amazon Bedrock в качестве управляемой системы дополненной генерации (RAG). Это позволяет вам гибко управлять документом политики, позволяя рабочему процессу извлекать только соответствующие сегменты политики для каждого входного сообщения. Это сводит к минимуму количество токенов, отправляемых в LLM для анализа.

Вы можете использовать Консоль управления AWS для загрузки документов политики в корзину S3, а затем индексировать документы в векторной базе данных для эффективного поиска. Ниже приведен концептуальный рабочий процесс, управляемый базой знаний Amazon Bedrock, который извлекает документы из Amazon S3, разбивает текст на фрагменты и вызывает модель встраивания текста Amazon Bedrock Titan для преобразования фрагментов текста в векторы, которые затем сохраняются в векторе. база данных.

В этом решении мы используем Amazon OpenSearch Service в качестве векторного хранилища. Открытый поиск — это масштабируемый, гибкий и расширяемый пакет программного обеспечения с открытым исходным кодом для приложений поиска, аналитики, мониторинга безопасности и наблюдения, лицензируемый по лицензии Apache 2.0. OpenSearch Service — это полностью управляемый сервис, который упрощает развертывание, масштабирование и эксплуатацию OpenSearch в облаке AWS.

После того как документ проиндексирован в службе OpenSearch, рабочий процесс модерации аудио и текста отправляет сообщения чата, запуская следующий поток запросов для оценки настроенной политики.

Этот процесс аналогичен рабочему процессу инициации. Сначала текстовое сообщение преобразуется во встроенный текст с помощью API Amazon Bedrock Titan Text Embedding. Эти внедрения затем используются для выполнения векторного поиска в базе данных службы OpenSearch, которая уже заполнена внедрениями документов. База данных возвращает фрагменты политики с наивысшим баллом соответствия, соответствующие входному текстовому сообщению. Затем мы составляем запросы, содержащие как входное сообщение чата, так и сегмент политики, которые отправляются в Anthropic Claude V2 для оценки. Модель LLM возвращает результат анализа на основе подсказок.

Подробные инструкции о том, как создать новый экземпляр с вашим документом политики в базе знаний Amazon Bedrock, см. в разделе «Базы знаний теперь обеспечивают полностью управляемый опыт RAG в Amazon Bedrock».

Рабочий процесс модерации текстового чата

Рабочий процесс модерации текстового чата аналогичен модерации аудио, но в нем используется анализ токсичности Amazon Comprehend, специально предназначенный для модерации текста. Пример приложения поддерживает интерфейс для массовой загрузки текстовых файлов в формате CSV или TXT и предоставляет интерфейс одного сообщения для быстрого тестирования. Следующая диаграмма иллюстрирует рабочий процесс.

Рабочий процесс модерации текста включает в себя следующие шаги:

- Пользователь загружает текстовый файл в корзину S3.

- К текстовому сообщению применяется анализ токсичности Amazon Comprehend.

- Если анализ токсичности возвращает показатель токсичности, превышающий определенный порог (например, 50%), мы используем базу знаний Amazon Bedrock для оценки сообщения на соответствие настроенным политикам с помощью Anthropic Claude V2 LLM.

- Отчет об оценке политики отправляется модератору.

Анализ токсичности Amazon Comprehend

В рабочем процессе модерации текста мы используем анализ токсичности Amazon Comprehend для оценки уровня токсичности текстовых сообщений. Amazon Comprehend — это сервис обработки естественного языка (NLP), который использует машинное обучение для выявления ценной информации и связей в тексте. API обнаружения токсичности Amazon Comprehend присваивает текстовому содержимому общую оценку токсичности в диапазоне от 0 до 1, что указывает на вероятность того, что оно является токсичным. Он также классифицирует текст по следующим категориям и предоставляет оценку достоверности для каждой: hate_speechграфика, harrassement_or_abuseсексуальный, violence_or_threatоскорбление и ненормативная лексика.

В этом рабочем процессе модерации текста анализ токсичности Amazon Comprehend играет решающую роль в определении того, содержит ли входящее текстовое сообщение токсичный контент. Подобно рабочему процессу модерации аудио, он включает условие для активации последующей оценки политики LLM только тогда, когда анализ токсичности возвращает оценку, превышающую заранее определенный порог. Эта оптимизация помогает снизить общую задержку и затраты, связанные с анализом LLM.

Краткое содержание

В этом посте мы представили решения для модерации аудио и текстовых чатов с использованием сервисов AWS, включая Amazon Transcribe, Amazon Comprehend, Amazon Bedrock и OpenSearch Service. В этих решениях используются предварительно обученные модели для анализа токсичности и сочетаются с генеративными LLM-технологиями искусственного интеллекта для достижения оптимального баланса точности, задержки и стоимости. Они также дают вам возможность гибко определять собственную политику.

Вы можете протестировать пример приложения, следуя инструкциям в Репозиторий GitHub.

Об авторе

Лана Чжан — старший архитектор решений в команде AWS WWSO AI Services, специализирующийся на искусственном интеллекте и машинном обучении для модерации контента, компьютерного зрения, обработки естественного языка и генеративного искусственного интеллекта. Благодаря своему опыту она занимается продвижением решений AWS AI/ML и помогает клиентам трансформировать их бизнес-решения в различных отраслях, включая социальные сети, игры, электронную коммерцию, средства массовой информации, рекламу и маркетинг.

Лана Чжан — старший архитектор решений в команде AWS WWSO AI Services, специализирующийся на искусственном интеллекте и машинном обучении для модерации контента, компьютерного зрения, обработки естественного языка и генеративного искусственного интеллекта. Благодаря своему опыту она занимается продвижением решений AWS AI/ML и помогает клиентам трансформировать их бизнес-решения в различных отраслях, включая социальные сети, игры, электронную коммерцию, средства массовой информации, рекламу и маркетинг.