Искусственный интеллект (ИИ) — это быстро развивающаяся область, способная улучшить и преобразовать многие аспекты жизни общества. В 2023 году темпы внедрения технологий искусственного интеллекта еще больше ускорились благодаря разработке мощных базовых моделей (FM) и, как следствие, развитию генеративных возможностей искусственного интеллекта.

В Amazon мы запустили несколько сервисов генеративного искусственного интеллекта, таких как Amazon Bedrock и Amazon CodeWhisperer, а также сделали ряд высокопроизводительных генеративных моделей доступными через Amazon SageMaker JumpStart. Эти услуги призваны помочь нашим клиентам раскрыть новые возможности генеративного искусственного интеллекта, включая повышение творческих способностей, создание персонализированного и динамического контента и инновационный дизайн. Они также могут позволить специалистам по искусственному интеллекту понять мир как никогда раньше — преодолевая языковые барьеры, изменение климата, ускоряя научные открытия и многое другое.

Однако, чтобы реализовать весь потенциал генеративного ИИ, важно тщательно обдумать любые потенциальные риски. В первую очередь, это приносит пользу заинтересованным сторонам системы ИИ, способствуя ответственной и безопасной разработке и внедрению, а также поощряя принятие упреждающих мер для устранения потенциального воздействия. Следовательно, создание механизмов оценки и управления рисками является важным процессом, который следует учитывать практикам ИИ, и стало ключевым компонентом многих новых отраслевых стандартов ИИ (например, ИСО 42001, ИСО 23894и НИСТ РМФ) и законодательства (например, Закон ЕС об искусственном интеллекте).

В этом посте мы обсудим, как оценить потенциальный риск вашей системы искусственного интеллекта.

Каковы различные уровни риска?

Хотя, возможно, было бы проще начать рассматривать отдельную модель машинного обучения (ML) и связанные с ней риски по отдельности, важно рассмотреть детали конкретного применения такой модели и соответствующего варианта использования как части целостной системы искусственного интеллекта. . Фактически, типичная система искусственного интеллекта, скорее всего, будет основана на нескольких различных моделях машинного обучения, работающих вместе, и организация может стремиться создать несколько разных систем искусственного интеллекта. Следовательно, риски можно оценивать для каждого варианта использования и на разных уровнях, а именно: риск модели, риск системы ИИ и корпоративный риск.

Корпоративный риск охватывает широкий спектр рисков, с которыми может столкнуться организация, включая финансовые, операционные и стратегические риски. Риск системы искусственного интеллекта фокусируется на воздействии, связанном с внедрением и эксплуатацией систем искусственного интеллекта, тогда как риск модели машинного обучения относится конкретно к уязвимостям и неопределенностям, присущим моделям машинного обучения.

В этом посте мы в первую очередь сосредоточимся на рисках системы ИИ. Однако важно отметить, что все уровни управления рисками внутри организации должны быть рассмотрены и согласованы.

Как определяется риск системы ИИ?

Управление рисками в контексте системы искусственного интеллекта может стать способом минимизировать эффект неопределенности или потенциальных негативных последствий, а также предоставить возможности для максимизации положительного воздействия. Риск сам по себе – это не потенциальный вред, а влияние неопределенности на цели. Согласно Система управления рисками NIST (NIST RMF), риск можно оценить как мультипликативную меру вероятности возникновения события, рассчитанную по величине последствий соответствующего события.

Существует два аспекта риска: неотъемлемый риск и остаточный риск. Неотъемлемый риск представляет собой величину риска, которому подвергается система ИИ при отсутствии средств смягчения или контроля. Остаточный риск отражает оставшиеся риски после учета стратегий смягчения.

Всегда помните, что оценка рисков — это человекоориентированная деятельность, требующая усилий всей организации; эти усилия варьируются от обеспечения включения в процесс оценки всех соответствующих заинтересованных сторон (например, групп по продуктам, инженерным разработкам, науке, продажам и безопасности) до оценки того, как социальные перспективы и нормы влияют на воспринимаемую вероятность и последствия определенных событий.

Почему вашей организации следует заботиться об оценке рисков?

Создание систем управления рисками для систем ИИ может принести пользу обществу в целом, способствуя безопасному и ответственному проектированию, разработке и эксплуатации систем ИИ. Системы управления рисками также могут принести пользу организациям благодаря следующему:

- Улучшенное принятие решений – Понимая риски, связанные с системами ИИ, организации могут принимать более обоснованные решения о том, как снизить эти риски и использовать системы ИИ безопасным и ответственным образом.

- Расширенное планирование соответствия – Система оценки рисков может помочь организациям подготовиться к выполнению требований по оценке рисков, предусмотренных соответствующими законами и нормативными актами.

- Укрепление доверия – Демонстрируя, что они принимают меры по снижению рисков, связанных с системами ИИ, организации могут показать своим клиентам и заинтересованным сторонам, что они привержены использованию ИИ безопасным и ответственным образом.

Как оценить риск?

В качестве первого шага организация должна рассмотреть возможность описания варианта использования ИИ, который необходимо оценить, и определить все соответствующие заинтересованные стороны. Вариант использования — это конкретный сценарий или ситуация, описывающая, как пользователи взаимодействуют с системой ИИ для достижения определенной цели. При создании описания варианта использования может быть полезно указать решаемую бизнес-задачу, перечислить участвующих заинтересованных сторон, охарактеризовать рабочий процесс и предоставить подробную информацию о ключевых входных и выходных данных системы.

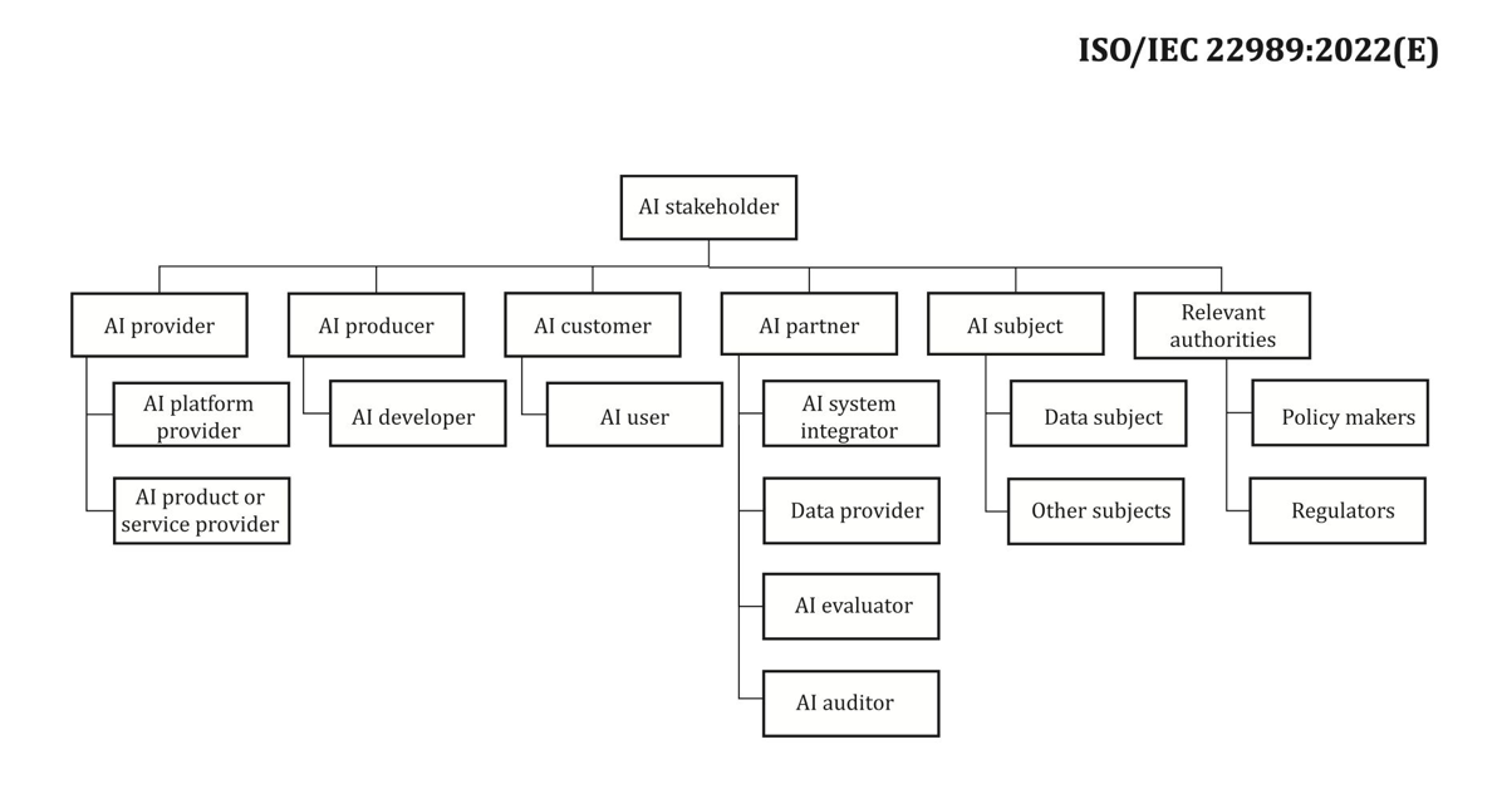

Когда дело доходит до заинтересованных сторон, некоторых легко упустить из виду. Следующий рисунок является хорошей отправной точкой для определения ролей заинтересованных сторон в области ИИ.

Источник: «Информационные технологии – Искусственный интеллект – Концепции и терминология искусственного интеллекта».

Важным следующим шагом оценки рисков системы ИИ является выявление потенциально вредных событий, связанных со сценарием использования. При рассмотрении этих событий может быть полезно задуматься о различных аспектах ответственного ИИ, таких как, например, справедливость и надежность. Различные заинтересованные стороны могут быть затронуты в разной степени по разным направлениям. Например, низкий риск надежности для конечного пользователя может быть результатом того, что система ИИ демонстрирует незначительные сбои, тогда как низкий риск справедливости может быть вызван тем, что система ИИ дает незначительно разные результаты для разных демографических групп.

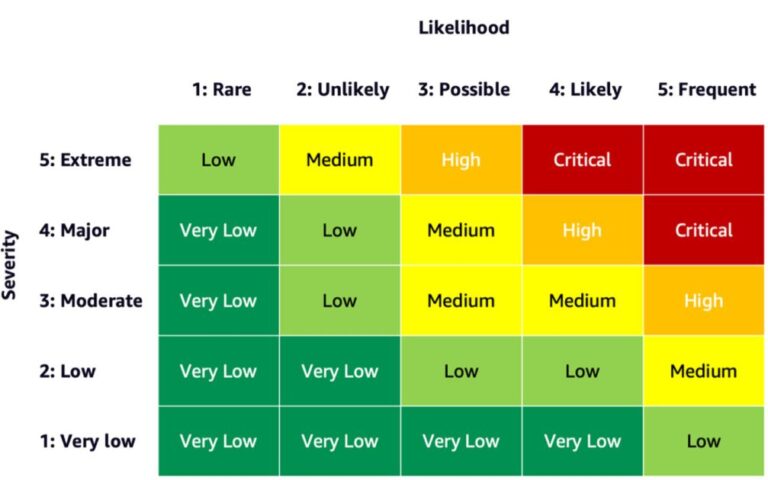

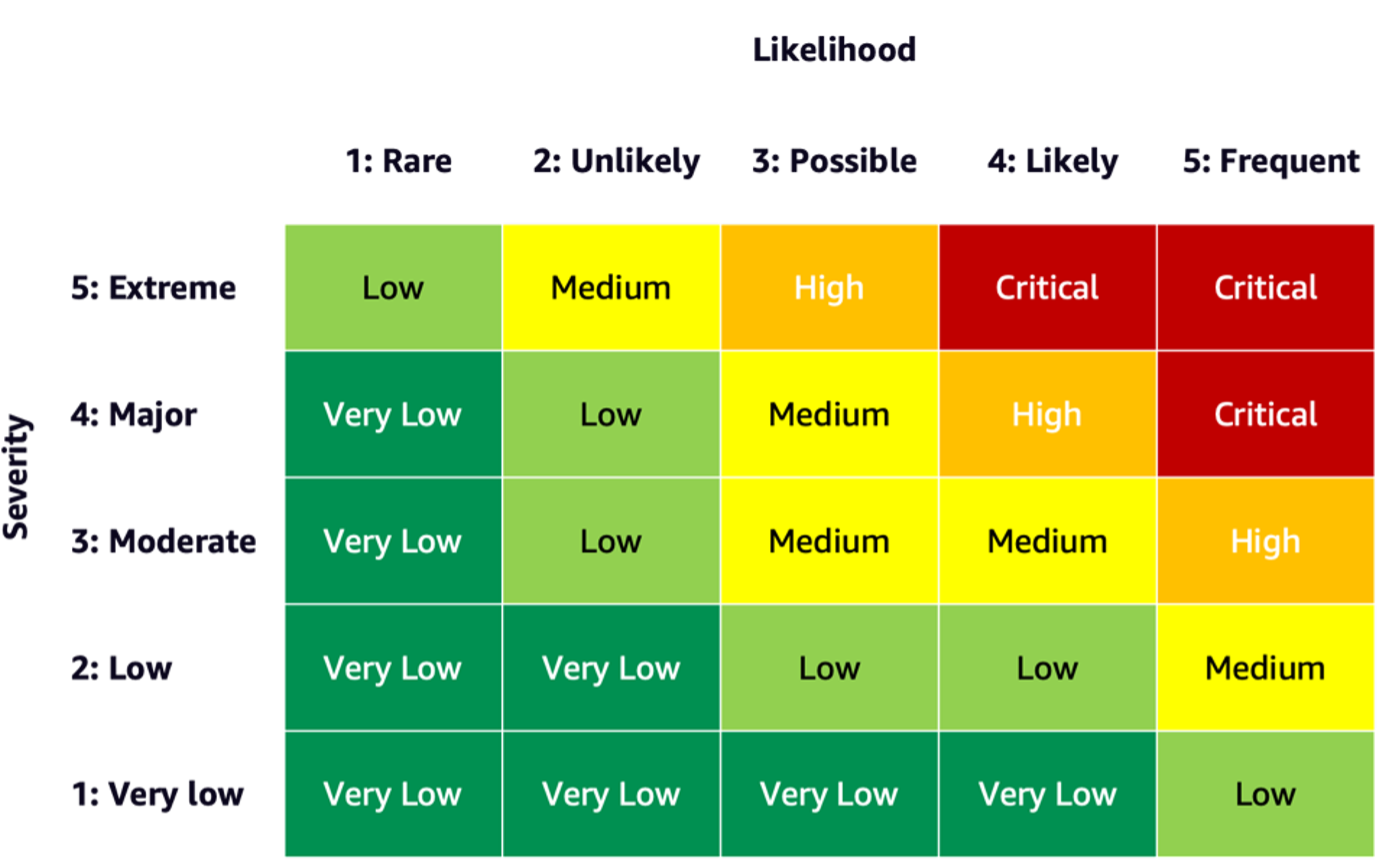

Чтобы оценить риск события, вы можете использовать шкалу вероятности в сочетании со шкалой серьезности для измерения вероятности возникновения, а также степени последствий. Полезной отправной точкой при разработке этих шкал может стать RMF NIST, которая предлагает использовать качественные нечисловые категории в диапазоне от очень низкого до очень высокого риска или принципы полуколичественной оценки, такие как шкалы (например, 1–10), ячейки или иные репрезентативные цифры. После того как вы определили шкалы вероятности и серьезности для всех соответствующих измерений, вы можете использовать схему матрицы рисков для количественной оценки общего риска для заинтересованных сторон по каждому соответствующему измерению. На следующем рисунке показан пример матрицы рисков.

Используя эту матрицу рисков, мы можем рассматривать событие с низкой серьезностью и редкой вероятностью возникновения как очень низкий риск. Имейте в виду, что первоначальная оценка будет представлять собой оценку неотъемлемого риска, а стратегии снижения риска могут помочь еще больше снизить уровни риска. Затем процесс можно повторить, чтобы получить рейтинг любого оставшегося остаточного риска для каждого события. Если по одному и тому же измерению выявлено несколько событий, может быть полезно выбрать среди всех самый высокий уровень риска, чтобы составить окончательную сводную оценку.

Используя итоговую сводку оценки, организациям придется определить, какие уровни риска приемлемы для их систем ИИ, а также рассмотреть соответствующие правила и политики.

Обязательства AWS

Благодаря взаимодействиям с белый дом и ООНПомимо прочего, мы стремимся делиться своими знаниями и опытом для продвижения ответственного и безопасного использования ИИ. В этом духе Адам Селипски из Amazon недавно представлял AWS на Саммит по безопасности ИИ на мероприятии присутствовали главы государств и лидеры отрасли, что еще раз продемонстрировало нашу приверженность сотрудничеству в области ответственного развития искусственного интеллекта.

Заключение

Поскольку ИИ продолжает развиваться, оценка рисков становится все более важной и полезной для организаций, стремящихся ответственно создавать и развертывать ИИ. Создав систему оценки рисков и план снижения рисков, организации могут снизить риск потенциальных инцидентов, связанных с ИИ, и завоевать доверие своих клиентов, а также получить такие преимущества, как повышение надежности, повышение справедливости для различных демографических групп и многое другое.

Начните свой путь разработки системы оценки рисков в вашей организации и поделитесь своими мыслями в комментариях.

Также ознакомьтесь с обзором рисков генеративного ИИ, опубликованным на Amazon Science: Ответственный ИИ в генеративную эпохуи изучите спектр сервисов AWS, которые могут помочь вам в оценке и снижении рисков: Amazon SageMaker Clarify, Amazon SageMaker Model Monitor, AWS CloudTrail, а также платформа управления моделями.

Об авторах

Миа С. Майер является ученым-прикладником и преподавателем машинного обучения в Университете машинного обучения AWS; где она исследует и преподает безопасность, объяснимость и справедливость систем машинного обучения и искусственного интеллекта. За свою карьеру Миа организовала несколько университетских программ, выступала в качестве приглашенного лектора и основного докладчика, а также выступала на многочисленных крупных учебных конференциях. Она также помогает внутренним командам и клиентам AWS начать ответственный путь в области искусственного интеллекта.

Миа С. Майер является ученым-прикладником и преподавателем машинного обучения в Университете машинного обучения AWS; где она исследует и преподает безопасность, объяснимость и справедливость систем машинного обучения и искусственного интеллекта. За свою карьеру Миа организовала несколько университетских программ, выступала в качестве приглашенного лектора и основного докладчика, а также выступала на многочисленных крупных учебных конференциях. Она также помогает внутренним командам и клиентам AWS начать ответственный путь в области искусственного интеллекта.

Денис Владимирович Баталов Денис с 17-летним стажем работы в Amazon и доктор философии в области машинного обучения работал над такими интересными проектами, как Search Inside the Book, мобильные приложения Amazon и Kindle Direct Publishing. С 2013 года он помогал клиентам AWS внедрять технологию AI/ML в качестве архитектора решений. В настоящее время Денис является мировым техническим руководителем в области искусственного интеллекта и машинного обучения, отвечающим за работу специалистов-архитекторов решений AWS ML по всему миру. Денис — частый оратор, вы можете следить за ним в Твиттере @dbatalov.

Денис Владимирович Баталов Денис с 17-летним стажем работы в Amazon и доктор философии в области машинного обучения работал над такими интересными проектами, как Search Inside the Book, мобильные приложения Amazon и Kindle Direct Publishing. С 2013 года он помогал клиентам AWS внедрять технологию AI/ML в качестве архитектора решений. В настоящее время Денис является мировым техническим руководителем в области искусственного интеллекта и машинного обучения, отвечающим за работу специалистов-архитекторов решений AWS ML по всему миру. Денис — частый оратор, вы можете следить за ним в Твиттере @dbatalov.

Доктор Сара Лю — старший менеджер технических программ в команде AWS по ответственному ИИ. Она работает с командой ученых, руководителями наборов данных, инженерами машинного обучения, исследователями, а также другими межфункциональными командами, чтобы поднять планку ответственного ИИ для сервисов AWS AI. Ее текущие проекты включают разработку карт услуг ИИ, проведение оценок рисков для ответственного ИИ, создание высококачественных наборов оценочных данных и реализацию программ качества. Она также помогает внутренним командам и клиентам соответствовать меняющимся отраслевым стандартам искусственного интеллекта.

Доктор Сара Лю — старший менеджер технических программ в команде AWS по ответственному ИИ. Она работает с командой ученых, руководителями наборов данных, инженерами машинного обучения, исследователями, а также другими межфункциональными командами, чтобы поднять планку ответственного ИИ для сервисов AWS AI. Ее текущие проекты включают разработку карт услуг ИИ, проведение оценок рисков для ответственного ИИ, создание высококачественных наборов оценочных данных и реализацию программ качества. Она также помогает внутренним командам и клиентам соответствовать меняющимся отраслевым стандартам искусственного интеллекта.