Введение

Переобучение и недостаточное оснащение — две наиболее распространенные проблемы, возникающие при машинном обучении.

В этой статье будут обсуждаться проблемы, с которыми мы сталкиваемся, а также то, как происходит переобучение и недостаточное оснащение. В статье говорится о том, что такое целевая функция. Как обобщение проявляется в машинном обучении. Что такое статистическое соответствие. Это поможет вам лучше понять смещение и дисперсию, поговорить о компромиссе между смещением и дисперсией. Речь пойдет о методах улучшения моделей машинного обучения.

Читайте также: Лучшие вопросы и ответы на собеседовании по Data Science

Что такое целевая функция в машинном обучении?

Можно предположить, что целевая функция является истинным предиктором, который может прогнозировать со 100% точностью любые будущие данные.

Используя обучение с учителем, мы пытаемся выбрать функцию из набора гипотетических функций, гарантируя при этом, что выбранная функция наиболее близка к целевой функции. Цель любой модели машинного обучения — максимально приблизить нас к целевой функции.

Что такое обобщение в машинном обучении

Цель машинного обучения — вывести общие понятия из конкретных примеров. Это называется индукцией. Обобщение — это процесс определения того, насколько хорошо невидимые точки данных работают с машинным обучением, выполненным на известном конкретном наборе наблюдений.

Обобщение является целью алгоритмов машинного обучения. Если конкретный алгоритм может хорошо работать с любой точкой данных в проблемной области, то он обобщается. Переобучение и недостаточное оснащение приводят к уменьшению обобщения, что приводит к снижению производительности.

Это статистическое соответствие?

Статистика и машинное обучение — это области, которые часто пересекаются.

Мы используем термин соответствовать чтобы понять, насколько мы близки к целевой функции. Под степенью соответствия понимается мера, используемая для оценки того, насколько хорошо модель соответствует целевой функции.

Машинное обучение и статистика — взаимосвязанные, а иногда и пересекающиеся области. Статистический вывод является основной целью статистики. Цель вывода — найти статистические свойства лежащих в основе данных и оценить неопределенность этих свойств. Однако при этом в области статистики были разработаны методы уменьшения размерности и регрессии, которые являются краеугольным камнем приложений машинного обучения.

Смещение и дисперсия

Ошибку прогнозирования машинного обучения можно разделить на две категории: смещение и дисперсию. Статистическое соответствие может быть достигнуто после понимания компромисса между низкой погрешностью и высокой дисперсией.

Смещение и дисперсия

Предвзятость

Относится к предположениям, сделанным в модели, чтобы легко изучить функцию модели. Мы также можем понимать предвзятость как частоту ошибок обучающих данных.

Более низкие коэффициенты ошибок называются низкая предвзятость. Примеры алгоритмов машинного обучения с низким смещением включают в себя: деревья решений, k-ближайшие соседи и SVM. Высокая частота ошибок называется высокая предвзятость. Примеры высокий предвзятость Алгоритмы машинного обучения включают: линейную регрессию, линейный дискриминантный анализ и логистическую регрессию.

Дисперсия

Дисперсия определяется как разница в частоте ошибок между данными обучения и тестирования. Когда дисперсия велика, ее называют высокая дисперсия. Когда дисперсия мала, ее называют низкий дисперсия.

Увеличение дисперсии снижает систематическую ошибку, и аналогичное увеличение систематической ошибки снижает дисперсию.

Переобучение в машинном обучении

Когда модель слишком хорошо изучает обучающие данные, это приводит к переобучению. Детали и шум в обучающих данных изучаются до такой степени, что это отрицательно влияет на производительность модели на новых данных.

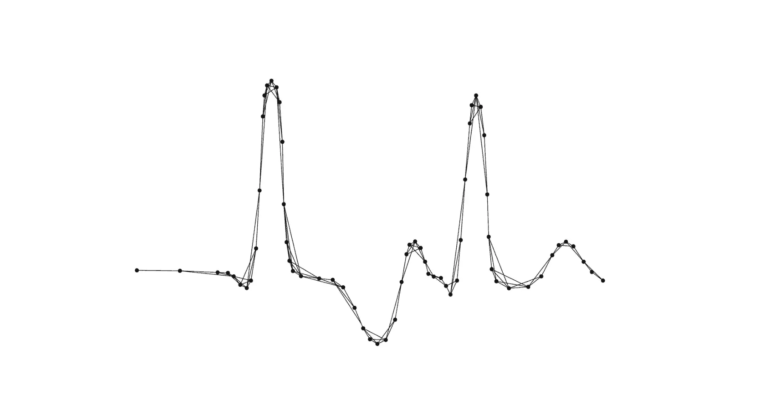

Желтая линия показывает модель, соответствующую данным.

Незначительные колебания и шум изучаются моделью как концепции. Это приводит к сбою модели при обнаружении новых данных.

Мощные алгоритмы, такие как дерево решений, которые используются для классификации и прогнозирования, склонны к переобучению. Дерево решений представляет собой древовидную структуру, похожую на блок-схему, где каждый внутренний узел обозначает проверку атрибута, каждая ветвь представляет результат проверки, а каждый листовой узел (конечный узел) содержит метку класса.

Что вызывает переобучение?

Существует множество причин, которые могут привести к переоснащению.

- Высокая дисперсия и низкая предвзятость

- Модель слишком сложна

- Размер обучающих данных

Как уменьшить переобучение?

- Увеличьте данные обучения.

- Уменьшите сложность модели.

- Регуляризация гребня и регуляризация лассо

- Используйте отсев для нейронных сетей, чтобы справиться с переоснащением.

Читайте также: Как использовать перекрестную проверку, чтобы уменьшить переобучение

Недостаточная оснащенность машинного обучения

Недооснащение

Когда модель не соответствует обучающим данным или новым данным, это называется недостаточным подбором. Обнаружить недостаточную подгонку легче, чем переобучение.

Что вызывает недостаточное оснащение?

- Высокая предвзятость и низкая дисперсия

- Размер используемого набора обучающих данных недостаточен.

- Модель слишком простая.

- Обучающие данные не очищаются и также содержат шум.

Как уменьшить недообучение?

- Увеличение сложности модели

- Увеличение количества функций, выполнение разработки функций

- Удалите шум из данных.

- Продолжительность тренировок следует увеличить.

Что такое хорошая посадка?

Модификация алгоритма для лучшего соответствия заданному набору данных приведет к низкой систематической ошибке, но увеличит дисперсию. Это приведет к тому, что модель будет делать неверные прогнозы.

В идеальном сценарии модель должна соответствовать как переоснащению, так и недостаточному оснащению, поскольку оба этих фактора могут привести к ухудшению производительности модели. В процессе обучения ошибки модели уменьшаются, как и ошибка обучения в наборе тестовых данных.

Давайте поговорим о методах, которые можно использовать, чтобы добиться хорошей посадки. Это помогает уменьшить переоснащение и недостаточное оснащение.

Компромисс между дисперсией и смещением

Увеличение сложности модели. для учета систематической ошибки и дисперсии, тем самым уменьшая общую систематическую ошибку и одновременно увеличивая дисперсию до приемлемого уровня. Это выравнивает модель с набором обучающих данных без существенных ошибок дисперсии.

Увеличение набора обучающих данных также может помочь в некоторой степени сбалансировать этот компромисс. Это предпочтительный метод при работе с моделями переоснащения. Более того, это позволяет пользователям увеличивать сложность без ошибок дисперсии, которые загрязняют модель, как в случае с большим набором данных.

Внедрить набор проверки

Набор проверки

После того, как модель прошла обучение на обучающем наборе. Набор проверки можно использовать для получения объективной оценки модели. Это гарантирует сохранение обобщения.

Правильная практика — когда вы получаете набор данных, отделите набор тестовых данных. Разделите оставшееся наблюдение на обучающий набор и набор проверки.

Перекрестная проверка

Перекрестная проверка использует различные наборы данных проверки для оценки моделей ML. В основном это используется для предотвращения переобучения. В случае перекрестной проверки данные проверки представляют собой смесь обучающих и реальных данных.

K-кратная перекрестная проверка: Это позволяет нам преодолеть проблему узкого места в одном тесте. В этом случае мы разбиваем набор данных на «k» складок. Затем использует одну из k сгибов в качестве набора проверки, а оставшуюся часть — в качестве обучающего набора.

Настройка гиперпараметров

Гиперпараметры — это параметры, определяющие архитектуру модели.

Мы можем попросить алгоритм ML предоставить нам комбинацию параметров и архитектуры для распределения наших данных. Процесс поиска параметров известен как настройка гиперпараметра.

Ансамблевые методы

Метод ансамбля используется для решения проблемы переобучения. Используя этот метод, мы в основном усредняют прогнозы группы прогнозных моделей.

Фактическим примером использования ансамблевого метода является Тесла, который использует ГидраНет, в беспилотных автомобилях. Автомобили Tesla получают данные от 8 разных камер. HydraNet достигает этого за счет использования ансамблевой архитектуры CNN.

Регуляризация

Регуляризация — это, по сути, упрощение набора данных и снижение его гибкости. Его можно использовать в случае параметрической и непараметрической модели.

Примечание. Регуляризация известна как сжатие.

Ранняя остановка.

Источник: Практическое машинное обучение с помощью scikit-learn, keras. и тензорный поток, Орельен Жерон, 2019 г.

По мере того как мы продолжаем обучать данные, ошибка в обучающих данных продолжает уменьшаться и в конечном итоге приводит к переобучению модели. Это происходит потому, что модель изучает шум в наборе обучающих данных, что приводит к уменьшению обобщения.

Также читайте: Pandas и большие фреймы данных: как читать частями

Заключение

В этой статье мы обнаружили проблемы, с которыми сталкиваются при машинном обучении. Мы сосредоточили внимание на переподгонке и недостаточной подгонке. Методы решения этих проблем, такие как перекрестная проверка, настройка гиперпараметров, ансамблевые методы, регуляризация и ранняя остановка. Использование смещения и дисперсии для прогнозирования ошибок и понимания торговли смещением дисперсии.

Читайте также: Что такое совместное распределение в машинном обучении?

Рекомендации

Браунли, Джейсон. «Как избежать переобучения в нейронных сетях глубокого обучения». MachineLearningMastery.Com16 декабря 2018 г., https://machinelearningmastery.com/introduction-to-regularization-to-reduce-overfitting-and-improve-generalization-error/. По состоянию на 15 февраля 2023 г.

Участники проектов Викимедиа. “Обобщение.” Википедия26 мая 2022 г., https://en.wikipedia.org/wiki/Обобщение. По состоянию на 15 февраля 2023 г.

—. “Индуктивное мышление.” Википедия6 февраля 2023 г., https://en.wikipedia.org/wiki/Inductive_reasoning. По состоянию на 15 февраля 2023 г.

—. «Переобучение». Википедия10 октября 2022 г., https://en.wikipedia.org/wiki/Overfitting. По состоянию на 15 февраля 2023 г.

Стив. «Андрей Карпатый подробно описывает автопилот за 10 минут». Обзор автопилота9 ноября 2019 г., https://www.autopilotreview.com/teslas-andrej-karpathy-details-autopilot-inner-workings/. По состоянию на 15 февраля 2023 г.

ТензорФлоу. «Решение проблем переоснащения и недостаточного оснащения вашей модели — часть 1 (кодирование TensorFlow)». YouTubeВидео, 11 окт. 2018 г., https://www.youtube.com/watch?v=GMrTBtzJkCg. По состоянию на 15 февраля 2023 г.

Понимание компромисса между смещением и дисперсией. http://scott.fortmann-roe.com/docs/BiasVariance.html. По состоянию на 15 февраля 2023 г.