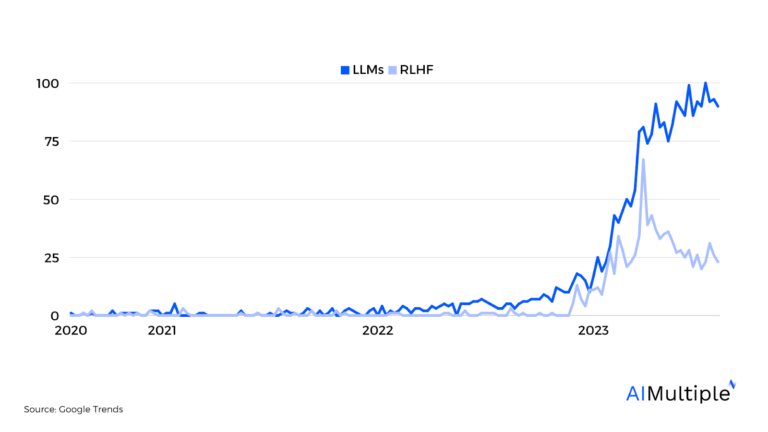

С появлением генеративного искусственного интеллекта и чат-ботов интерес к программам LLM за последние пару лет быстро вырос. Однако RLHF продемонстрировал относительно меньший рост (рис. 1). Несмотря на впечатляющие результаты в разработке искусственного интеллекта, генеративного искусственного интеллекта и LLM, RLHF — это относительно новый подход, о котором многие люди до сих пор не знают.

Чтобы восполнить этот пробел в знаниях, в этой статье исследуется взаимосвязь между двумя аббревиатурами, какую пользу RLHF дает большим языковым моделям, и проводится сравнение ведущих поставщиков услуг RLHF.

Рисунок 1. Глобальный онлайн-интерес между RLHF и LLM

Что такое RLHF (обучение с подкреплением и обратной связью с человеком)?

Обучение с подкреплением, или RL, — это подход машинного обучения, при котором алгоритмы учатся, получая обратную связь, обычно в форме функции вознаграждения. Традиционный метод предполагает обучение модели прогнозированию наилучшего возможного действия в данном сценарии на основе автоматизированной системы вознаграждения.

RLHF делает еще один шаг вперед, привлекая людей к процессу обучения. Он предполагает интеграцию обратной связи с людьми в систему вознаграждений. Благодаря обратной связи с человеком модель машинного обучения получает уточненные направления, корректируя свое поведение на основе данных о предпочтениях человека.

Как это работает?

В основе тренировочного процесса RLHF лежит модель вознаграждения. Вместо того, чтобы полагаться исключительно на заранее определенные критерии, он учитывает обратную связь от людей в процессе обучения.

Упрощенное объяснение включало бы две языковые модели: исходную языковую модель, генерирующую текстовый вывод, и слегка модифицированную версию. Затем рецензенты оценивали качество текстовых результатов, полученных с помощью обеих моделей.

Такое сравнение текста, созданного человеком, помогает автоматизированной системе понять, какие результаты более желательны, позволяя модели вознаграждения развиваться.

Это динамичный процесс, в котором человеческая обратная связь и модель вознаграждения развиваются вместе, направляя подход машинного обучения.

Рисунок 2. Процесс обучения с подкреплением с обратной связью от человека

Что такое LLM (большие языковые модели)?

Большие языковые модели, или LLM, находятся в авангарде революции искусственного интеллекта и машинного обучения в обработке естественного языка. Эти модели машинного обучения предназначены для понимания и генерации текста, имитируя возможности человеческого общения.

LLM строятся на огромных объемах текстовых данных и проходят строгие процессы обучения. Их сила очевидна в их способности создавать связный и контекстуально релевантный текст на основе предоставленных им первоначальных обучающих данных.

Как их обучают?

Обучение больших языковых моделей — непростая задача. Все начинается с начальной языковой модели, построенной на разнообразном наборе обучающих данных. Эта предварительно обученная языковая модель затем настраивается на основе конкретных задач или областей.

Учитывая сложность человеческого языка и обработки естественного языка, крайне важно, чтобы такие модели подвергались многочисленным итерациям уточнения. Хотя эти модели могут учиться на огромных объемах данных, настоящая задача заключается в том, чтобы они давали точные и детальные ответы. Вот тут-то и вступает в игру RLHF.

Спонсор

Clickworker предлагает услуги RLHF для LLM через краудсорсинговую платформу. Ее глобальная сеть, насчитывающая более 4,5 миллионов сотрудников, обслуживает 4 из 5 технологических гигантов в США. Clickworker также специализируется на подготовке обучающих данных для LLM и других систем искусственного интеллекта, в том числе:

- Создание и сбор изображений, аудио, видео и текстовых данных.

- Выполнение услуг РЛХФ

- Обработка наборов данных для машинного обучения

- Проведение исследований и опросов

- Проведение анализа настроений.

Какую пользу метод RLHF может принести студентам LLM?

Симбиотические отношения между RLHF и LLM изменили правила игры в области обработки языков, управляемой искусственным интеллектом. Давайте выясним, как это сделать.

1. Более совершенные программы LLM

В парадигме RLHF исходная модель обучается с использованием традиционных методов. Эта модель, несмотря на свою мощь, все еще имеет возможности для совершенствования. Благодаря интеграции обратной связи с человеком модель уточняется на основе сигналов вознаграждения, предоставляемых человеком.

Этот процесс включает в себя обучение LLM с использованием функций вознаграждения, полученных на основе отзывов людей. Это не только уточняет параметры модели, но и обеспечивает ее более точное соответствие нормам человеческого общения.

2. Гибкая среда обучения

Вместо статической, заранее определенной системы вознаграждений динамическая модель вознаграждения, дополненная человеком, создает гибкую среду обучения. Когда модель генерирует текст, обратная связь не просто проверяет правильность, но и оценивает нюансы, контекст и актуальность. Такой подход гарантирует, что сгенерированные текстовые результаты не только технически правильны, но и контекстуально и эмоционально согласованы.

3. Постоянное улучшение

Подход RLHF не является разовым процессом. Модель вознаграждения продолжает развиваться, принимая во внимание все более детальную обратную связь от людей. Эта непрерывная эволюция гарантирует, что по мере изменения языковых тенденций и появления новых языковых нюансов большая языковая модель остается обновленной и актуальной.

4. Более высокий уровень безопасности и надежности.

Использование RLHF позволяет разработчикам выявлять и устранять непредвиденное поведение модели. Получая обратную связь от людей, можно исправить потенциальные проблемы, предвзятости или неточности в результатах модели, гарантируя, что ответы модели будут более безопасными и надежными. Этот интерактивный подход обеспечивает более надежную модель, менее подверженную ошибкам или противоречивым результатам.

Зачем работать с поставщиком услуг RLHF для разработки LLM?

Разработка LLM может оказаться ресурсоемким и трудоемким процессом, если она выполняется собственными силами. Сотрудничество с поставщиком услуг RLHF может предложить различные преимущества в процессе разработки большой языковой модели.

1. Опыт интеграции обратной связи с людьми

Поставщики услуг RLHF привносят глубокое понимание того, как эффективно интегрировать обратную связь с людьми в процесс обучения. Их опыт гарантирует, что обратная связь, полученная от людей, не просто учитывается, но и оптимально используется для обучения ИИ.

2. Создание эффективной функции вознаграждения

Учитывая, что функции вознаграждения играют ключевую роль в процессе RLHF, опыт поставщика услуг RLHF гарантирует точность, актуальность и эффективность этих функций. Они устраняют разрыв между пониманием языка LLM и человеческими разговорными нормами.

3. Масштабируемость и постоянное совершенствование

Сотрудничество с партнером RLHF гарантирует, что LLM не просто подвергается первоначальной доработке, но и постоянно совершенствуется. Такие партнерства создают инфраструктуру, в которой в систему поступает регулярная обратная связь от людей, как положительная, так и отрицательная, гарантируя, что модель остается первоклассной.

4. Больше разнообразия

Поставщики услуг RLHF обычно работают с краудсорсинговой платформой или большой сетью сотрудников. Это может гарантировать, что обратная связь, которую получает модель, будет разнообразной и охватит широкий спектр человеческого опыта и точек зрения.

Привлекая рецензентов из разных регионов и культур, аутсорсинговый подход может помочь в обучении модели, более ориентированной на глобальный уровень. Это особенно важно для программ LLM, которые предназначены для обслуживания глобальной аудитории, гарантируя, что они не отражают только одну региональную или культурную точку зрения.

Сравнение лучших поставщиков услуг RLHF на рынке

В этом разделе сравниваются ведущие поставщики услуг RLHF на рынке.

Таблица 1. Сравнение категорий присутствия на рынке

| Компания | Размер толпы | Доля клиентов среди топ-5 покупателей | Отзывы клиентов |

|---|---|---|---|

| Кликворкер | 4,5 млн+ | 80% | – G2: 3,9 – Трастпилот: 4.4 — Каптерра: 4,4 |

| Appen | 1 млн+ | 60% | – Г2: 4,3 — Каптерра: 4.1 |

| Плодовитый | 130 тыс.+ | 40% | – Г2: 4,3 – Трастпилот: 2,7 |

| Всплеск ИИ | Н/Д | 60% | Н/Д |

| Толока А.И. | 245 тыс.+ | 20% | – Трастпилот: 2,8 — Каптерра: 4.0 |

Таблица 2: Сравнение категорий набора функций

| Компания | Мобильное приложение | Доступность API | Сертификация ISO 27001 | Нормы поведения | Соответствие GDPR |

|---|---|---|---|---|---|

| Кликворкер | истинный | истинный | истинный | истинный | истинный |

| Appen | истинный | истинный | истинный | истинный | истинный |

| Плодовитый | ЛОЖЬ | истинный | ЛОЖЬ | истинный | истинный |

| Всплеск ИИ | ЛОЖЬ | истинный | истинный | ЛОЖЬ | ЛОЖЬ |

| Толока А.И. | истинный | истинный | истинный | истинный | истинный |

Примечания и наблюдения из таблиц:

- Критерии отбора компаний будут обновляться по мере развития рынка и развития нашего понимания рынка.

- Информация о возможностях компании не проверена. Предполагается, что поставщик услуг предлагает возможность, если эта возможность упоминается на странице его услуг или в тематических исследованиях по состоянию на август 2023 г. Возможно, в будущем мы проверим заявления компаний.

- Возможности компании не измерялись количественно. Мы проверили, были ли предложены возможности или нет. В ходе сравнительного анализа продуктов в будущем можно будет ввести количественные показатели.

- Все данные, добавленные в таблицы, основаны на заявлениях компаний.

- Компании, выбранные для этого сравнения, были основаны на актуальности их услуг.

- Все поставщики услуг предлагают возможности интеграции API.

Как найти подходящего поставщика услуг RLHF для вашего проекта?

В этом разделе перечислены критерии, которые мы использовали для выбора поставщиков услуг RLHF, сравниваемых в этой статье. Читатели также могут использовать этот критерий, чтобы найти подходящий вариант для своего бизнеса. Критерии разделены на 2 категории:

- Присутствие на рынке

- Набор функций

Присутствие на рынке

1. Доля клиентов среди топ-5 покупателей

Чтобы понять присутствие компании на рынке и получить представление о ее значимости и доминировании на рынке, изучите ее клиентуру среди пяти крупнейших технологических гигантов:

- Samsung

- Яблоко

- Майкрософт

- Мета

2. Отзывы пользователей

Ознакомьтесь с обзорами G2 и Trustpilot, чтобы получить представление о работе компании. Убедитесь, что отзывы соответствуют конкретной услуге, которую вы рассматриваете, поскольку компании предлагают разнообразные услуги.

Набор функций

3. Возможности платформы

Изучите возможности поставщика услуг. Предоставляют ли они мобильное приложение или интеграцию API?

4. Практика защиты данных

Учитывая рост киберугроз, надежная защита данных имеет жизненно важное значение. Мы искали сертификацию ISO 27001 и соответствие GDPR.

5. Справедливая торговля

Этика вашего партнера влияет на вашу репутацию. Убедитесь, что они поддерживают справедливую практику для работников.

дальнейшее чтение

Если вам нужна помощь в поиске поставщика или у вас есть вопросы, свяжитесь с нами: