По мере того, как мир все больше склоняется к технологическим инновациям, приоритетность генеративного ИИ стала приоритетом для многих отраслей, выводя творчество и автоматизацию на новый уровень. Однако существуют серьезные потенциальные риски генеративного искусственного интеллекта, включая его точность и этичное использование. Поэтому крайне важно распознавать и решать эти проблемы, обеспечивая будущее, в котором технологии служат наилучшим интересам человечества.

В этой статье мы объясним 5 основных рисков генеративного ИИ и предложим шаги по их снижению.

1- Риски точности генеративного ИИ

Инструменты генеративного ИИ, такие как ChatGPT, полагаются на большие языковые модели, которые обучаются на массивных данных. Чтобы ответить на вопрос или создать ответ на определенную подсказку, эти модели интерпретируют подсказку и вызывают ответ на основе данных обучения. Хотя их обучающие наборы данных состоят из миллиардов параметров, они представляют собой конечные пулы, и генеративные модели могут время от времени «придумывать» ответы.

Может быть много потенциальных рисков для точности, вызванных генеративными моделями ИИ:

- Обобщение важнее конкретики: Поскольку генеративные модели предназначены для обобщения данных, на которых они обучаются, они не всегда могут давать точную информацию для конкретных, детальных запросов или запросов вне выборки.

- Отсутствие проверки: генеративные модели могут давать информацию, которая кажется правдоподобной, но неточной или ложной. Без внешней проверки или проверки фактов пользователи могут быть введены в заблуждение.

- Нет источника правды: Генеративный ИИ не имеет собственного «источника правды». Он не «знает» вещи так, как это делают люди, с контекстом, этикой или проницательностью. Он генерирует результаты на основе шаблонов данных, а не фундаментального понимания.

Как смягчить:

Снижение рисков точности генеративного ИИ требует сочетания технических и процедурных стратегий. Вот несколько способов устранения этих рисков:

- Качество и разнообразие данных: Убедитесь, что ИИ обучен высококачественным, разнообразным и репрезентативным данным. При этом увеличивается вероятность того, что ИИ даст точные результаты по широкому кругу запросов.

- Регулярные обновления моделей: Постоянно обновляйте модель ИИ новыми данными, чтобы повысить ее точность и адаптироваться к изменяющимся информационным ландшафтам.

- Внешняя проверка: Всегда подтверждайте результаты генеративного ИИ другими надежными источниками, особенно для критически важных приложений. Проверка фактов и проверка домена имеют важное значение.

- Обучение пользователей: расскажите пользователям о сильных сторонах и ограничениях ИИ. Пользователи должны понимать, когда полагаться на результаты ИИ, а когда искать дополнительную проверку.

2- Риски смещения генеративного ИИ

Способность генеративного ИИ увековечивать или даже усиливать предубеждения — еще одна серьезная проблема. Подобно рискам точности, поскольку генеративные модели обучаются на определенном наборе данных, смещения в этом наборе могут привести к тому, что модель также будет генерировать предвзятое содержимое. Предубеждения ИИ могут включать сексистские, расистские или эйблистские подходы в онлайн-сообществах.

Некоторые риски предвзятости генеративного ИИ:

- Предвзятость представления: если группы или точки зрения меньшинств недостаточно представлены в обучающих данных, модель может не давать результаты, отражающие эти группы, или могут представлять их в ложном свете.

- Усиление существующих предубеждений: даже если первоначальная погрешность в обучающих данных незначительна, ИИ иногда может усилить ее из-за того, как он оптимизирует шаблоны и популярные тренды.

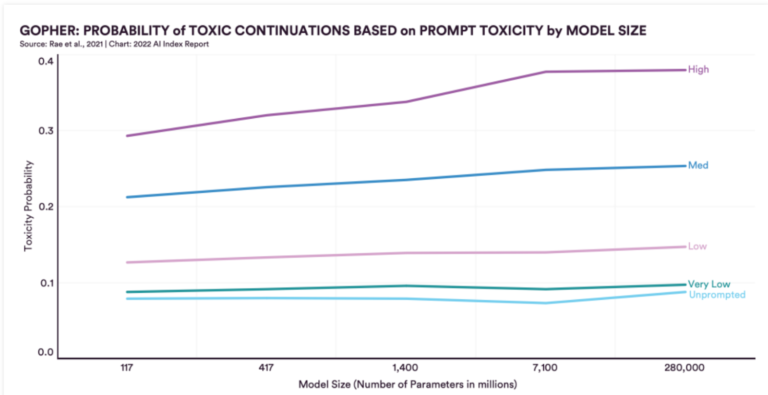

Например, по сравнению с моделью со 117 миллионами параметров, разработанной в 2018 году, недавно созданная модель с 280 миллиардами параметров продемонстрировала огромное увеличение уровня токсичности на 29%. По мере того, как эти системы превращаются в еще более мощные центры исследований и разработок в области ИИ, также существует потенциал для увеличения риска предвзятости. Вы можете увидеть эту тенденцию на рисунке ниже, где уровень токсичности генерируемых ответов увеличивается с увеличением размера параметра.

Источник: Стэнфордский отчет об индексе искусственного интеллекта за 2022 г.1

Как смягчить:

- Разнообразные тренировочные данные может помочь уменьшить предвзятость представления.

- Непрерывный мониторинг и оценка выходных данных модели может помочь выявить и исправить систематические ошибки.

- Этические принципы и надзор для разработки и развертывания ИИ может помочь контролировать предубеждения.

3- Конфиденциальность данных и риски безопасности генеративного ИИ

Технология генеративного ИИ, особенно модели, обученные на огромных объемах данных, создают определенные риски в отношении конфиденциальности конфиденциальных данных. Вот некоторые из основных опасений:

- Утечка данных: даже если ИИ предназначен для создания нового контента, существует вероятность того, что он может непреднамеренно воспроизвести фрагменты обучающих данных. Если обучающие данные содержат конфиденциальную информацию, существует риск ее раскрытия.

- Неправомерное использование персональных данных: Если генеративный ИИ обучается на личных данных клиентов без надлежащей анонимизации или без получения необходимых разрешений, он может нарушить правила конфиденциальности данных и этические стандарты.

- Проблемы происхождения данных: Учитывая, что генеративные модели могут создавать огромное количество контента, может быть сложно отследить происхождение любого конкретного фрагмента данных. Это может привести к трудностям в установлении прав на данные и их происхождения.

Как смягчить:

Тем не менее, использование генеративных моделей для создания синтетических данных является хорошим способом защиты конфиденциальных данных. Некоторые шаги для смягчения угроз безопасности данных могут быть следующими:

- Дифференциальная конфиденциальность: в процессе обучения можно использовать такие методы, как дифференциальная конфиденциальность, чтобы гарантировать, что выходные данные модели не будут тесно связаны с какими-либо отдельными входными данными. Это помогает защитить отдельные точки данных в наборе обучающих данных.

- Синтетические обучающие наборы данных: Чтобы снизить риски безопасности данных, генеративные модели можно обучать на синтетических данных, которые ранее были сгенерированы моделями ИИ.

- Маскировка данных: Перед обучением моделей ИИ наборы данных можно обработать, чтобы удалить или изменить личную информацию.

- Регулярные проверки и проверки: регулярный аудит выходных данных ИИ на предмет потенциальных утечек данных или нарушений может помочь в раннем обнаружении и устранении нарушений.

4- Риски интеллектуальной собственности генеративного ИИ

Генеративный ИИ бросает вызов традиционным нормам и правилам интеллектуальной собственности (ИС). Кроме того, существуют опасения по поводу приемлемости созданного ИИ контента для защиты и нарушения авторских прав, которые мы подробно обсуждаем в нашей статье.

Эти проблемы с интеллектуальной собственностью трудно решить, учитывая сложный характер контента, создаваемого ИИ. Например, посмотрите на картину «Следующий Рембрандт» на рисунке ниже. Его трудно отличить от оригинальной картины Рембрандта.

Источник: Гардиан2

Некоторые из основных рисков и проблем генеративного ИИ в отношении интеллектуальной собственности:

- Оригинальность и право собственности: Если генеративный ИИ создает музыкальное произведение, произведение искусства или письмо, кому принадлежат авторские права? Является ли это разработчиком ИИ, пользователем, который им управлял, или можно сказать, что никто не создал его напрямую и, следовательно, он не подлежит авторскому праву? Это проблематичные концепции, когда речь идет о создании ИИ.

- Лицензирование и права использования: Аналогично, как следует лицензировать контент, созданный с помощью ИИ? Если ИИ создает контент на основе обучающих данных, лицензированных на определенных условиях (например, Creative Commons), какие права применяются к новому контенту?

- нарушение: генеративные модели могут непреднамеренно создавать результаты, напоминающие произведения, защищенные авторским правом. Поскольку они обучены работе с огромными объемами данных, они могут непреднамеренно воссоздать последовательности или шаблоны, являющиеся собственностью.

- Обнаружение плагиата: распространение контента, созданного искусственным интеллектом, может затруднить обнаружение плагиата. Если две модели ИИ, обученные на одинаковых наборах данных, дают одинаковые результаты, отличить оригинальный контент от плагиата становится сложно.

Как смягчить:

- Четкие правила и политики: установление четких рекомендаций по использованию ИИ для создания контента и решения вопросов, связанных с ИС, может помочь ориентироваться в этом сложном ландшафте.

- Совместные усилия: Отраслевые органы, юристы и технологи должны сотрудничать, чтобы пересмотреть нормы ИС в контексте ИИ.

- Технологические решения: Блокчейн и другие технологии могут использоваться для отслеживания и проверки происхождения и подлинности контента, созданного ИИ.

5- Этические риски генеративного ИИ

На протяжении многих лет велась серьезная дискуссия об этике ИИ. Однако этические дебаты вокруг генеративного ИИ начались относительно недавно. Этот разговор набрал обороты с введением различных генеративных моделей, в частности ChatGPT и DALL-E от OpenAI.

- Дипфейки: Самая большая этическая проблема, связанная с генеративным ИИ, — это дипфейки. Генеративные модели теперь могут генерировать фотореалистичные изображения, видео и даже звуки людей. Такой контент, созданный ИИ, может быть трудно или невозможно отличить от реальных медиа, что создает серьезные этические последствия. Эти поколения могут распространять дезинформацию, манипулировать общественным мнением или даже преследовать или клеветать на отдельных лиц. Например, видео ниже — это драматический дипфейк с участием Барака Обамы.

- Эрозия человеческого творчества: чрезмерная зависимость от ИИ для творческих задач потенциально может снизить ценность человеческого творчества и оригинальности. Если контент, созданный ИИ, станет нормой, это может привести к гомогенизации культурных и творческих произведений.

- Влияние на безработицу: Если отрасли будут широко использовать генеративный ИИ для создания контента, это может вытеснить людей из таких областей, как писательство, дизайн, музыка и многое другое. Это может привести к потере рабочих мест и экономическим сдвигам, которые имеют этические последствия.

- Проблемы окружающей среды: Обучение больших генеративных моделей требует значительных вычислительных ресурсов, которые могут иметь значительный углеродный след. Это поднимает этические вопросы о воздействии разработки и использования таких моделей на окружающую среду.

Как смягчить:

- Взаимодействие с заинтересованными сторонами: Взаимодействуйте с различными заинтересованными сторонами, включая специалистов по этике, представителей сообщества и пользователей, чтобы понять потенциальные этические ловушки и найти решения.

- Инициативы прозрачности: следует приложить усилия, чтобы сделать процессы и намерения ИИ прозрачными для пользователей и заинтересованных сторон. Это включает в себя водяные знаки или маркировку контента, созданного ИИ.

- Этические принципы: организации могут разрабатывать и придерживаться этических принципов, специально предназначенных для решения проблем, связанных с генеративным ИИ.

Если у вас есть вопросы или вам нужна помощь в поиске поставщиков, мы можем помочь:

Найдите подходящих поставщиков

- «Отчет об индексе искусственного интеллекта за 2022 год». Индекс ИИ, https://aiindex.stanford.edu/wp-content/uploads/2022/03/2022-AI-Index-Report_Master.pdf. По состоянию на 1 января 2023 г.

- Браун, Марк. «Новый Рембрандт» будет представлен в Амстердаме». Хранитель, 5 апреля 2016 г., https://www.theguardian.com/artanddesign/2016/apr/05/new-rembrandt-to-be-unveiled-in-amsterdam. По состоянию на 21 августа 2023 г.