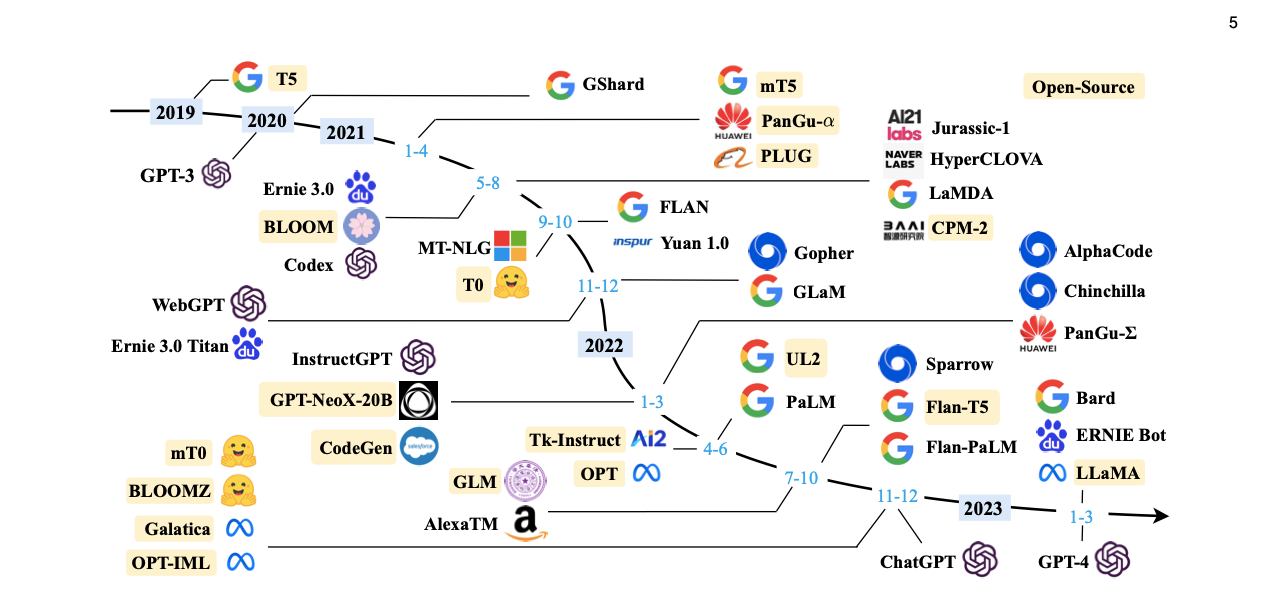

С 2019 года количество больших языковых моделей llms увеличивается (см. рис. 1) благодаря обширным областям применения и возможностям моделей. Тем не менее, оценки показывают, что разработка новой базовой модели может стоить до 90 миллионов долларов, а тонкая настройка или усовершенствование существующих больших языковых моделей может стоить от 1 до 100 тысяч долларов. 1 Столь высокие и неустойчивые затраты являются результатом:

- Фиксированные факторы, такие как затраты на оборудование, учебные прогоны, сбор и маркировка данных.

- Различные факторы: затраты на персонал и НИОКР или вычислительные затраты.

LLMOps может помочь снизить затраты, упрощая операционные задачи. Однако LLMOps — относительно недавние решения, рыночная среда которых может сбить с толку бизнес-лидеров и ИТ-специалистов.

В этой статье кратко объясняется рынок LLMOps и сравниваются доступные инструменты.

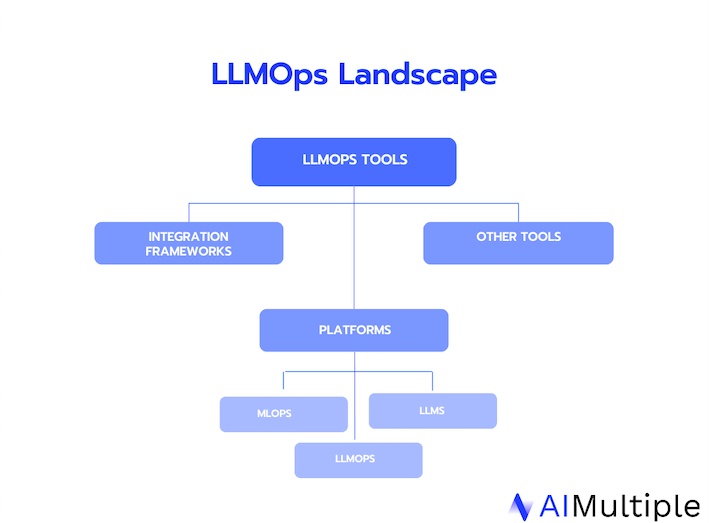

Пейзаж LLMOps

На рынке существует более 20 инструментов, которые претендуют на роль LLMOps, которые можно оценить по трем категориям:

1. ) Платформы LLMOps

Платформы либо разрабатываются снизу, не обязательно предназначены для LMMOps, но они предлагают несколько возможностей, которые могут быть полезны для обучения таких моделей, как большие языковые модели. Вот некоторые из этих особенностей:

- Тонкая настройка llms

- Управление версиями и развертывание LLM.

Эти платформы LLM могут предлагать различные уровни гибкости и простоты использования:

- Платформы LLM без кода: Некоторые из этих платформ не содержат кода и содержат мало кода, что облегчает внедрение LLM. В этом смысле их можно оценить как LLMOps. Однако эти инструменты обычно имеют ограниченную гибкость.

- Платформы, ориентированные на код: Эти широкие платформы ориентированы на модели процессов машинного обучения, включая LMM и базовые модели, — сочетание высокой гибкости и легкого доступа к вычислениям для опытных пользователей.

Фреймворки интеграции

Эти инструменты созданы для простой разработки приложений LLM (например, LangChain). Эти фреймворки могут предлагать анализ документов, анализ кода и чат-ботов.

Другие инструменты

Эти инструменты оптимизируют меньшую часть рабочего процесса LLM, например, тестовые подсказки, включение обратной связи с человеком (RLHF) или оценка наборов данных.

Отказ от ответственности

Мы знаем, что существуют разные подходы к классификации этих инструментов. Например, некоторые поставщики включают другие технологии, которые могут помочь в разработке больших языковых моделей в этой среде, такие как контейнеризация или граничные вычисления. Однако такие технологии не предназначены для проектирования или мониторинга моделей, хотя их можно использовать в сочетании с инструментами LLMOps для повышения производительности модели. Поэтому мы исключили эти инструменты.

Более классический подход классифицирует их на основе типа лицензии (например, с открытым исходным кодом или нет) и предварительно обученных или нет. Несмотря на то, что этот подход точен, он не может объяснить существенных различий между инструментами LLMOps. Кроме того, последние исследования показывают, что фокус LLM и генеративного ИИ в целом смещается в сторону проприетарного из открытого исходного кода.3 Поэтому мы не акцентировали внимание на этом аспекте в нашем бенчмаркинге.

В нашем анализе мы удалили интеграционные платформы и другие соответствующие инструменты и сосредоточились на платформах LLMOps. Следуя классификации, описанной выше, мы перечислили и представили инструменты:

1. Платформы MLOP

Некоторые платформы MLOps можно развернуть как инструменты LLMOP, такие как Zen ML. MLOps, или операции машинного обучения, эффективно управляют и оптимизируют сквозной жизненный цикл машинного обучения.

Сравните все платформы MLOP в нашем постоянно обновляемом списке поставщиков..

2.) Платформы LLM

Некоторые из этих платформ и сред построены как LLM, которые могут предлагать функции операционных инструментов LLM. Откройте для себя такие большие языковые модели (llms) в нашем полном списке.

3.) Платформы LLMOP

В эту категорию входят любые инструменты, предназначенные исключительно для оптимизации и управления операциями LLM. В таблице ниже показаны звезды Github, обзоры B2B и средний балл B2B на авторитетных страницах обзоров B2B (Trustradius, Gartner и G2) для некоторых из этих инструментов LLMOps:

| Инструменты LLMOps | Гитхаб Звезды | Количество обзоров B2B* | Средняя оценка по отзывам** |

|---|---|---|---|

| Глубокое озеро | 6600 | нет данных | нет данных |

| Точная настройка ИИ | 6000 | нет данных | нет данных |

| Шноркель ИИ | 5500 | нет данных | нет данных |

| Дзен мл | 3000 | нет данных | нет данных |

| Ламини ИИ | 2100 | нет данных | нет данных |

| комета | 54 | нет данных | нет данных |

| Титан МЛ | 47 | нет данных | нет данных |

| Валохай | Не с открытым исходным кодом | 20 | 4.9 |

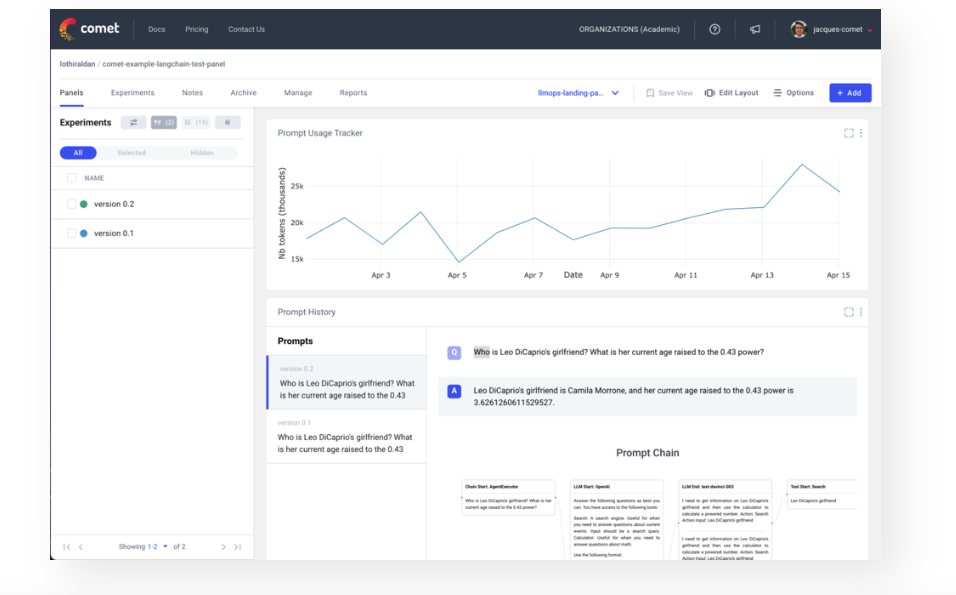

- Комета: Comet оптимизирует жизненный цикл машинного обучения, отслеживая эксперименты и производственные модели. Он подходит для крупных корпоративных групп и предлагает различные стратегии развертывания. Он поддерживает частное облако, гибридные и локальные установки.

- Глубокое озеро: Deep Lake сочетает в себе возможности озер данных и векторных баз данных для создания, уточнения и внедрения высококачественных решений LLM и MLOps для бизнеса. Deep Lake позволяет пользователям визуализировать наборы данных и управлять ими в своем браузере или блокноте Jupyter, быстро получая доступ к различным версиям и создавая новые с помощью запросов, совместимых с PyTorch и TensorFlow.

- Точный ИИ: Fine-turner AI — это платформа без кода, которую можно подключить с помощью плагинов No-Code, сторонних инструментов и остальных API. Она позволяет создавать агентов AI с помощью настраиваемых агентов AI без сложных технических навыков.

- Ламини ИИ: Lamini AI предоставляет простой метод обучения LLM посредством быстрой настройки и обучения базовой модели. Пользователи Lamini AI могут писать собственный код, интегрировать собственные данные и размещать полученный LLM в своей инфраструктуре.

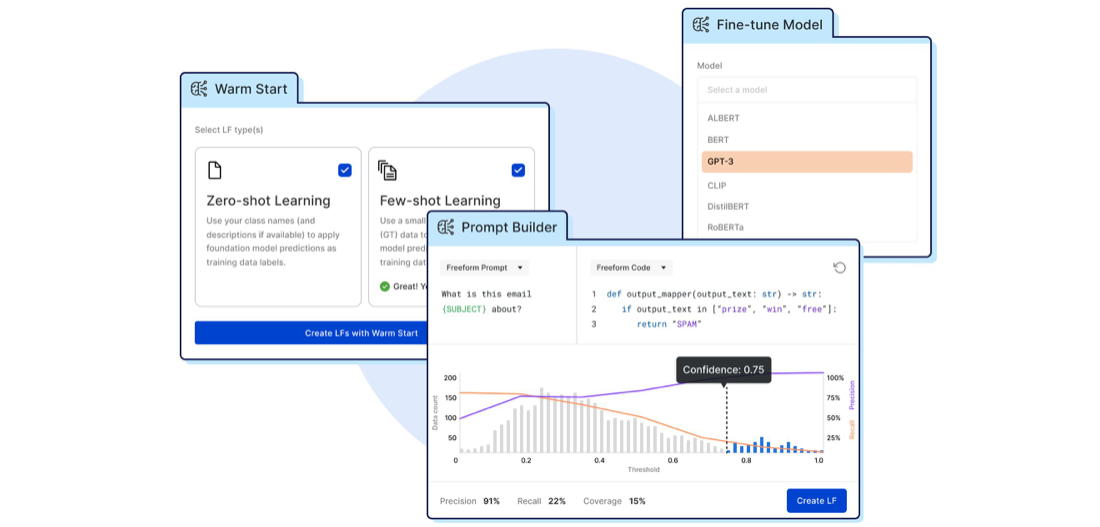

- Шноркель ИИ: Snorkel AI позволяет предприятиям создавать или настраивать базовые модели (FM) и большие языковые модели (LLM) для достижения исключительной точности наборов данных и вариантов использования, специфичных для предметной области. Snorkel AI представляет программную маркировку, позволяющую разрабатывать ИИ, ориентированный на данные, с помощью автоматизированных процессов.

6. Титан МЛ: TitanML — это платформа разработки NLP, цель которой — позволить предприятиям быстро создавать и внедрять небольшие и более экономичные развертывания больших языковых моделей. Он предлагает запатентованные, автоматизированные, эффективные методы тонкой настройки и оптимизации логического вывода. Таким образом, это позволяет предприятиям самостоятельно создавать и развертывать большие языковые модели.

7. Валохай: Valohai оптимизирует MLOps и LLM, автоматизируя извлечение данных для развертывания модели. Он может хранить модели, эксперименты и артефакты, что упрощает мониторинг и развертывание. Valohai создает эффективный рабочий процесс от кода до развертывания, поддерживая записные книжки, сценарии и проекты Git.

8. Дзен МЛ: ZenML в первую очередь фокусируется на операциях машинного обучения (MLOPs) и управлении рабочим процессом машинного обучения, включая подготовку данных, эксперименты и развертывание моделей.

При выборе инструмента необходимо учитывать несколько факторов:

- Определите цели: Четко обозначьте свои бизнес-цели, чтобы заложить прочную основу для процесса выбора инструмента LLMOps. Например, если ваша цель требует обучения модели с нуля, а не тонкой настройки существующей модели, это будет иметь важные последствия для вашего стека LLMOps.

- Определите требования: В зависимости от вашей цели, определенные требования станут более важными. Например, если вы хотите, чтобы бизнес-пользователи могли использовать LLM, вы можете не включать код в свой список требований.

- Подготовьте шорт-лист: учитывайте отзывы и отзывы пользователей, чтобы получить представление о реальном опыте работы с различными инструментами LLMOps. Положитесь на эти рыночные данные, чтобы подготовить шорт-лист.

- Сравните функциональность: Используйте бесплатные пробные версии и демонстрации, предоставляемые различными инструментами LLMOps, чтобы лично сравнить их функции и функциональные возможности.

Что такое LLMOps?

Модели большого языка (LLM) — это усовершенствованные модели машинного обучения, предназначенные для понимания и создания текста, похожего на человеческий, на основе шаблонов и информации, полученной на основе обучающих данных. Эти модели строятся с использованием моделей глубокого обучения для учета сложных лингвистических нюансов и контекста.

LLMOps относятся к методам и инструментам, используемым для управления операционными моделями LLM в производственной среде.

дальнейшее чтение

Узнайте больше о LLM, MLOps и AIOps, прочитав наши статьи:

Внешние источники

- “Дорожная карта генерального директора по генеративному ИИ.” БЦЖ. Март 2023 г. Повторное посещение 11 августа 2023 г.

- “Обзор больших языковых моделей.” Гитхаб. Март 2023 г. Повторное посещение 11 августа 2023 г.

- “Дорожная карта генерального директора по генеративному ИИ.” БЦЖ. Март 2023 г. Повторное посещение 11 августа 2023 г.

- “Отладка моделей больших языков с помощью инструментов Comet LLMOps». комета. Повторное посещение 16 августа 2023 г.

- Харви, Н. (20 марта 2023 г.). “Snorkel Flow Spring 2023: теплые старты и базовые модели.” ТрубкаAI. Повторное посещение 16 августа 2023 г.

Будьте в курсе B2B Tech