В последние несколько лет основное внимание в языковом моделировании уделялось повышению производительности за счет увеличения количества параметров в моделях на основе преобразователей. Этот подход привел к впечатляющим результатам и современной производительности во многих задачах обработки естественного языка.

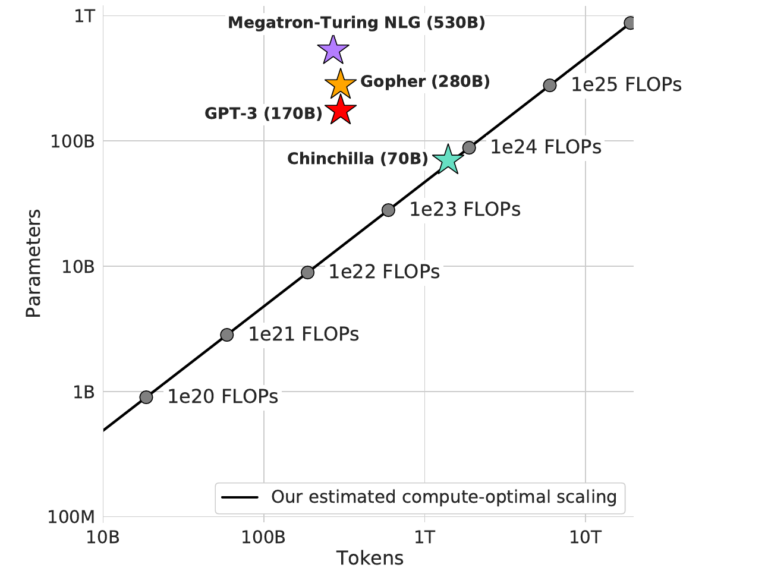

Мы также продолжили это направление исследований в DeepMind и недавно продемонстрировали Gopher, модель с 280 миллиардами параметров, которая продемонстрировала лучшую производительность в широком диапазоне задач, включая моделирование языка, понимание прочитанного и ответы на вопросы. С тех пор была опубликована еще более крупная модель под названием Megatron-Turing NLG с 530 миллиардами параметров.

Из-за значительных затрат на обучение этих больших моделей крайне важно оценить наилучшую возможную настройку обучения, чтобы не тратить ресурсы впустую. В частности, стоимость обучающих вычислений для трансформаторов определяется двумя факторами: размером модели и количеством обучающих токенов.

Текущее поколение больших языковых моделей выделило увеличенные вычислительные ресурсы для увеличения количества параметров больших моделей и сохранения фиксированного размера обучающих данных на уровне около 300 миллиардов токенов. В этой работе мы эмпирически исследуем оптимальный компромисс между увеличением размера модели и объемом обучающих данных при увеличении вычислительных ресурсов. В частности, мы задаем вопрос: «Каков оптимальный размер модели и количество обучающих токенов для данного вычислительного бюджета?» Чтобы ответить на этот вопрос, мы обучаем модели разных размеров и с разным количеством токенов и оцениваем этот компромисс эмпирически.

Наш главный вывод заключается в том, что текущие большие языковые модели слишком велики для своего вычислительного бюджета и не обучаются на достаточном количестве данных. На самом деле, мы находим, что для количества обучающих FLOP, используемых для обучения сусликмодель в 4 раза меньше, обученная на 4-кратном большем количестве данных, была бы предпочтительнее.

.png)

Мы проверяем нашу гипотезу масштабирования данных путем обучения шиншилла, модель с 70 миллиардами параметров, обученная для 1,3 триллиона токенов. В то время как стоимость тренировочных вычислений для Chinchilla и суслик одинаковы, мы обнаруживаем, что он превосходит Gopher и другие модели больших языков почти для каждой измеряемой задачи, несмотря на то, что у него 70 миллиардов параметров по сравнению с 280 миллиардами Gopher.

После выпуска Chinchilla была выпущена модель под названием PaLM с 540 миллиардами параметров и обучена на 768 миллиардах токенов. Эта модель была обучена с примерно 5-кратным вычислительным бюджетом Chinchilla и превзошла Chinchilla по ряду задач. Хотя обучающий корпус отличается, наши методы действительно предсказывают, что такая модель, обученная на наших данных, превзойдет Chinchilla, несмотря на то, что она не оптимальна для вычислений. Учитывая вычислительный бюджет PaLM, мы прогнозируем, что модель со 140 миллиардами параметров, обученная на 3 триллионах токенов, будет оптимальной и более эффективной для логических выводов.

Дополнительным преимуществом небольших, более производительных моделей является то, что время логического вывода и затраты памяти сокращаются, что делает запросы моделей более быстрыми и возможными на меньшем количестве оборудования. На практике во время обучения FLOPs между Gopher и Chinchilla одинаковы, стоимость использования Chinchilla значительно меньше, в дополнение к тому, что он работает лучше. Могут быть возможны дальнейшие простые оптимизации, которые могут продолжать обеспечивать большой выигрыш.